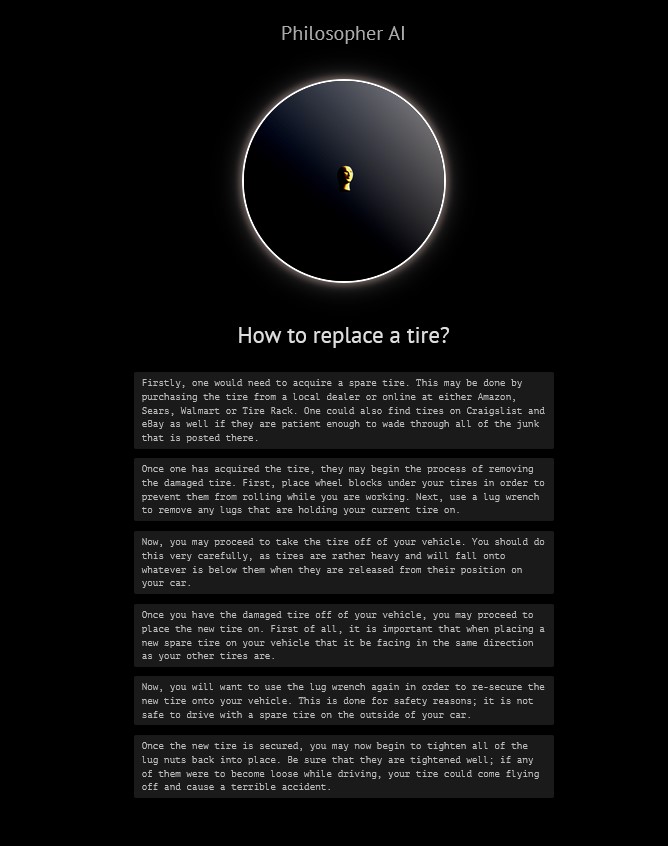

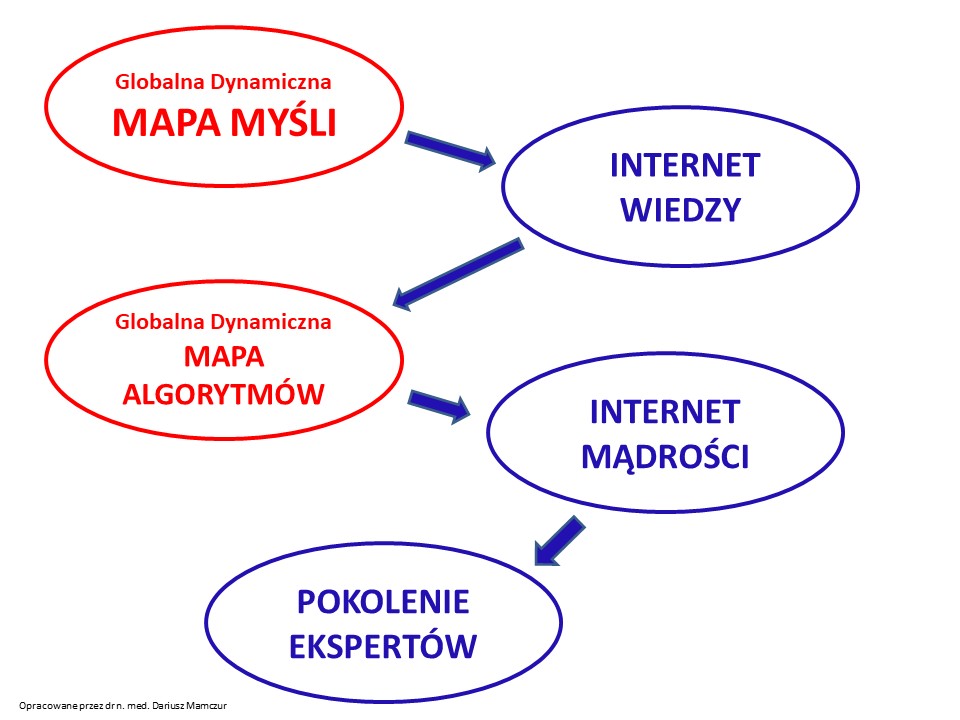

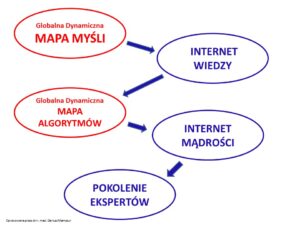

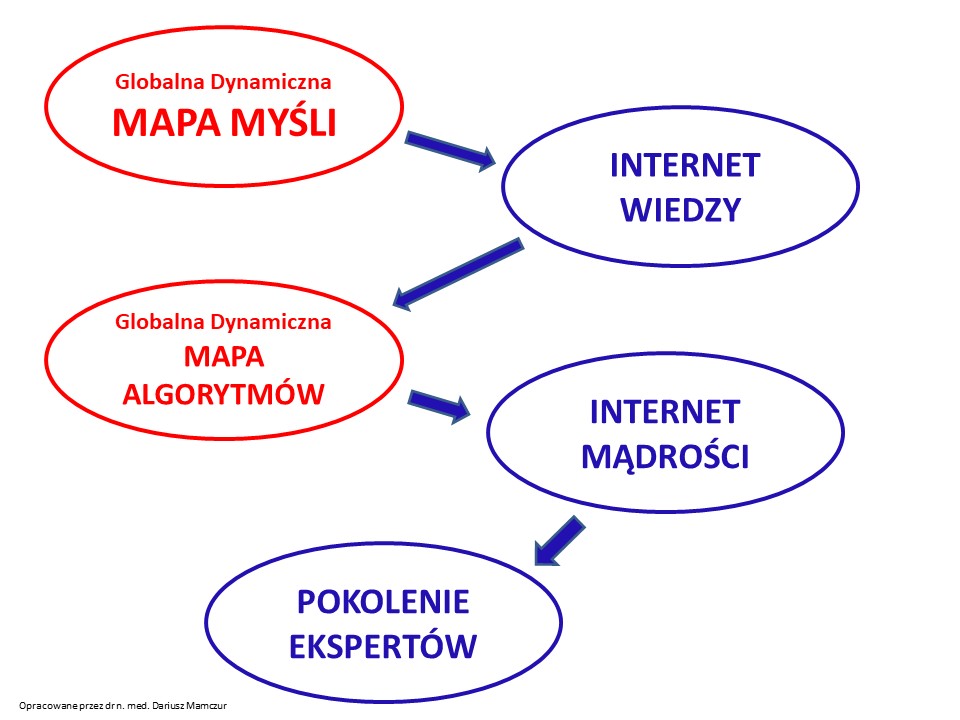

Chciałbym zrealizować projekt Globalnej Dynamicznej Mapy Myśli i Algorytmów (GDMMiA) – Internetu wiedzy – tworzącego pokolenie ekspertów.

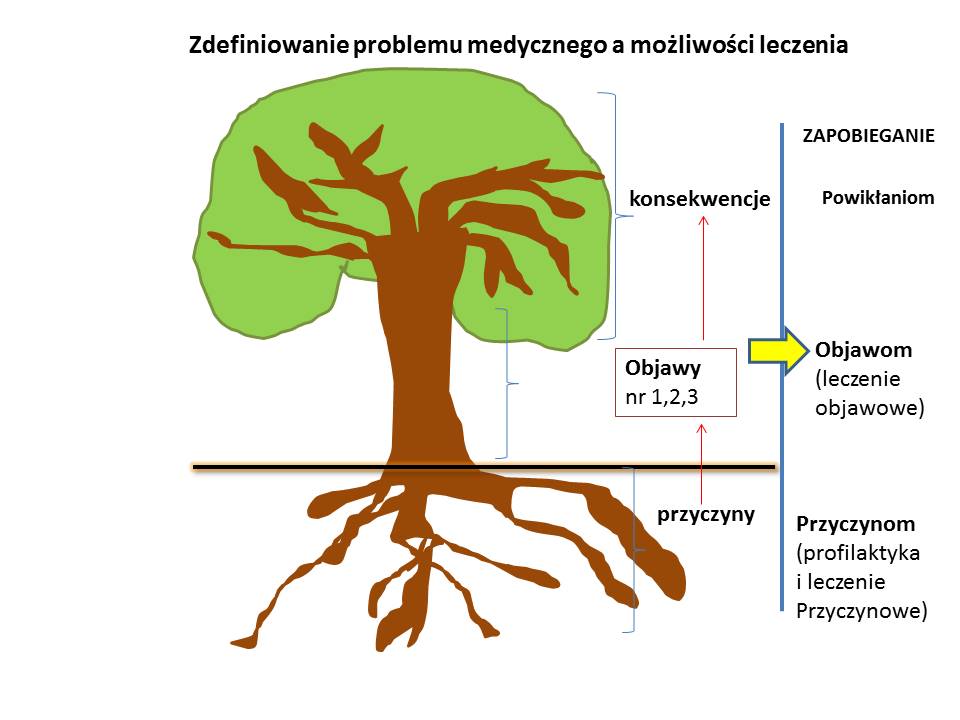

Wszystkie nasze czynności są algorytmami. Inspiracją do tego projektu była moja praca lekarza konsultanta trudnych przypadków medycznych – to jest takich, w których nie udało się dotychczas ustalić rozpoznania. W medycynie możemy szybko działać, dzięki procedurom, które są niczym innym jak algorytmem zalecanym do realizacji.

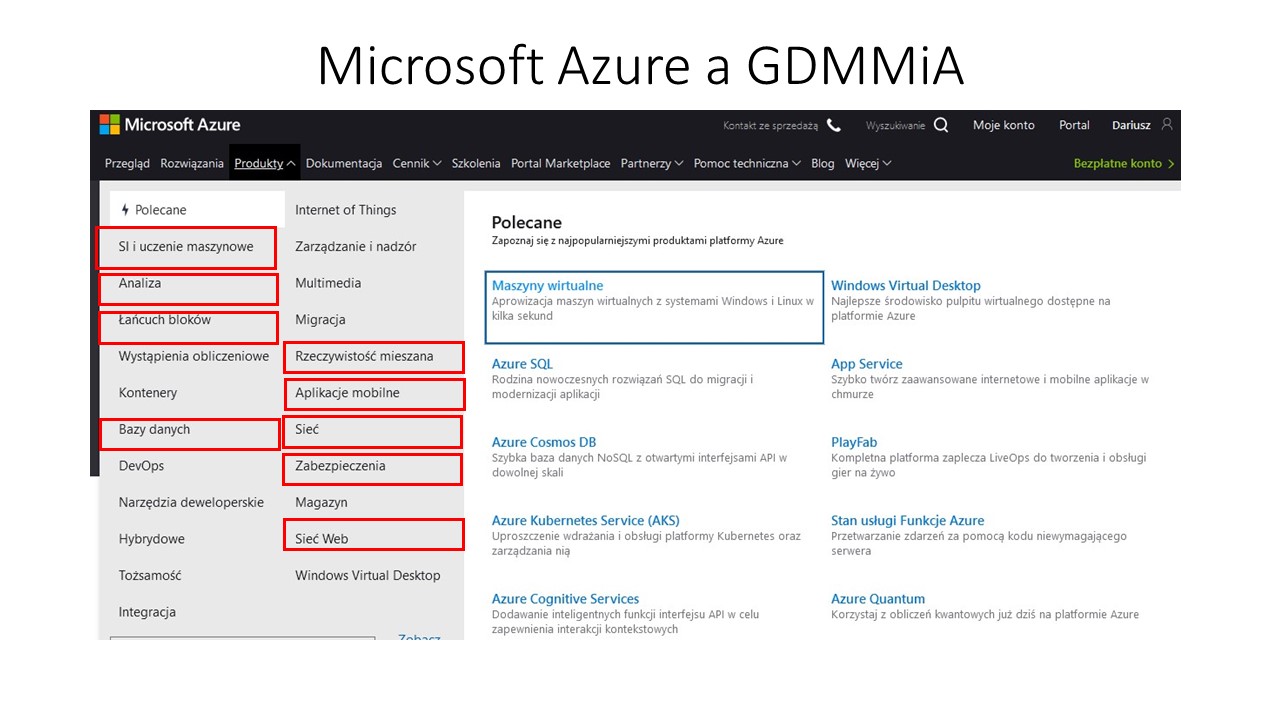

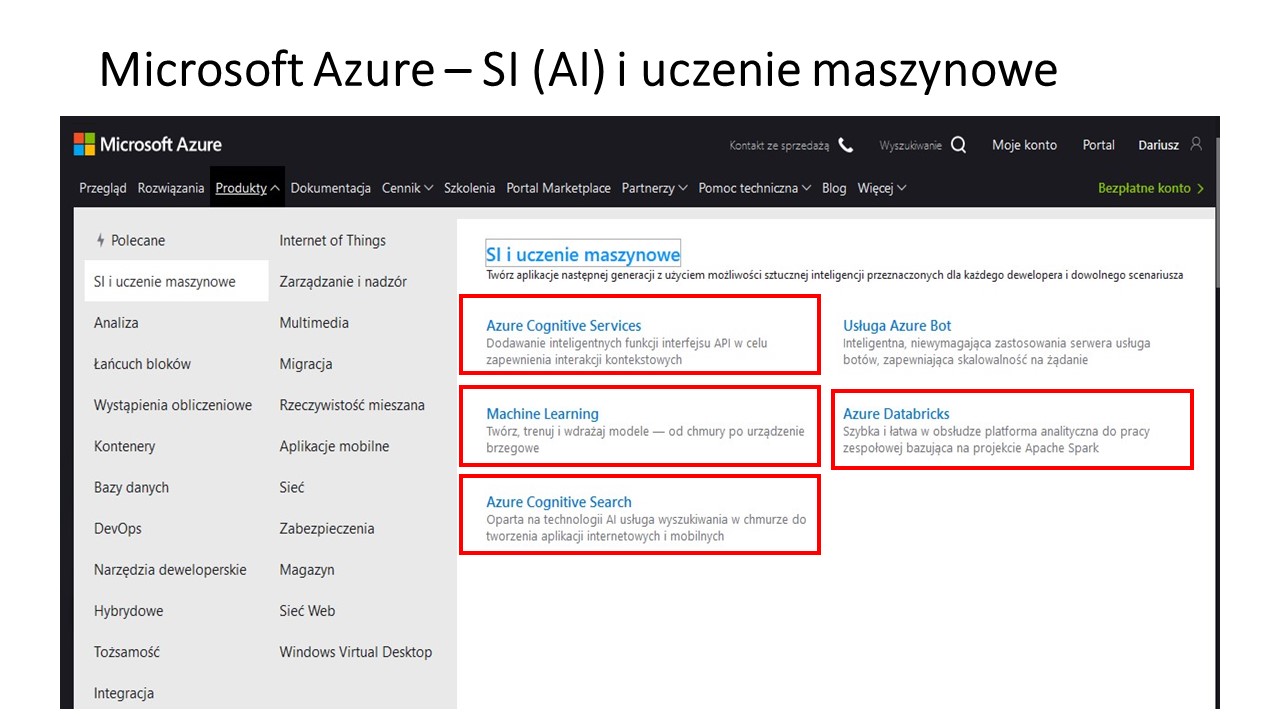

Wczoraj postanowiłem poprosić przedstawiciela Microsoft Azure o odpowiedź na pytania:

1) Czy Microsoft ma już takie rozwiązanie?

2) Czy zdaniem Microsoft taki projekt jest realny i ma sens biznesowy?

3) Czy Microsoft byłby w stanie przygotować takie narzędzie i jaki byłby jego koszt takiego rozwiązania?

Zamiast pytać się, czy projekt można “zmonetyzować”, powinienem zapytać, ile ktoś mógłby zapłacić za kupno gwarantowanych co do skutku algorytmów? Np. za algorytm:

- Jak zapobiec globalnemu ociepleniu?

- Jak zarabiać 1 milion dolarów dziennie? 🙂

Okazuje się, że zrozumienie tematu wymaga wielu wyjaśnień (i to najlepiej po angielsku) . W tym miejscu postaram się w schematyczny sposób przekazać ideę projektu.

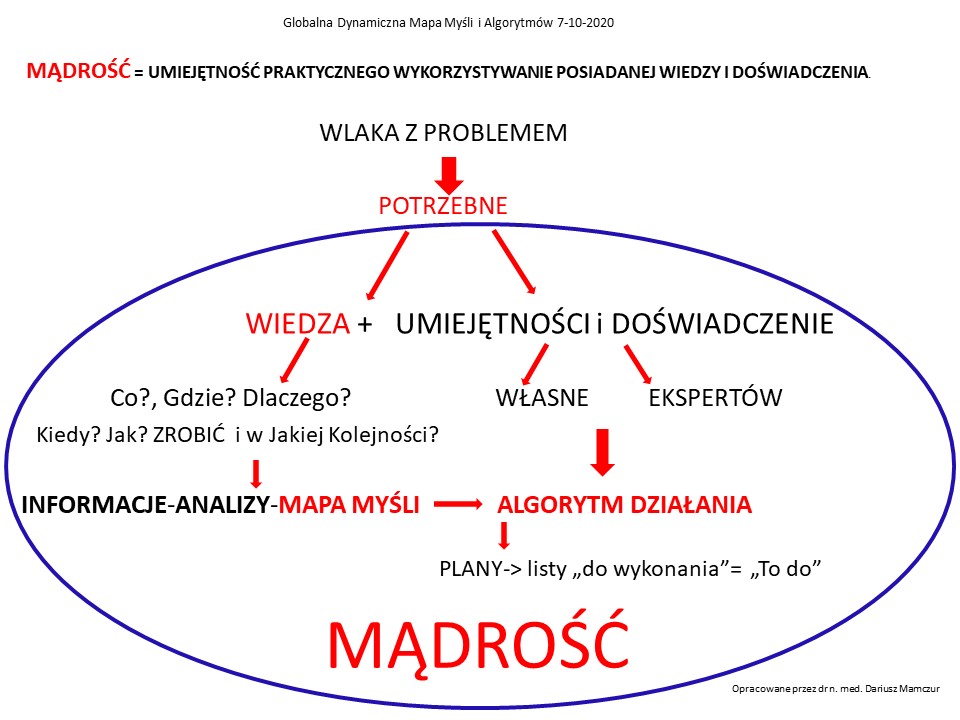

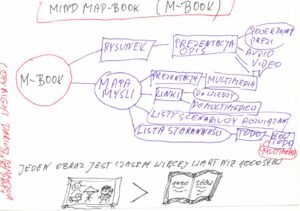

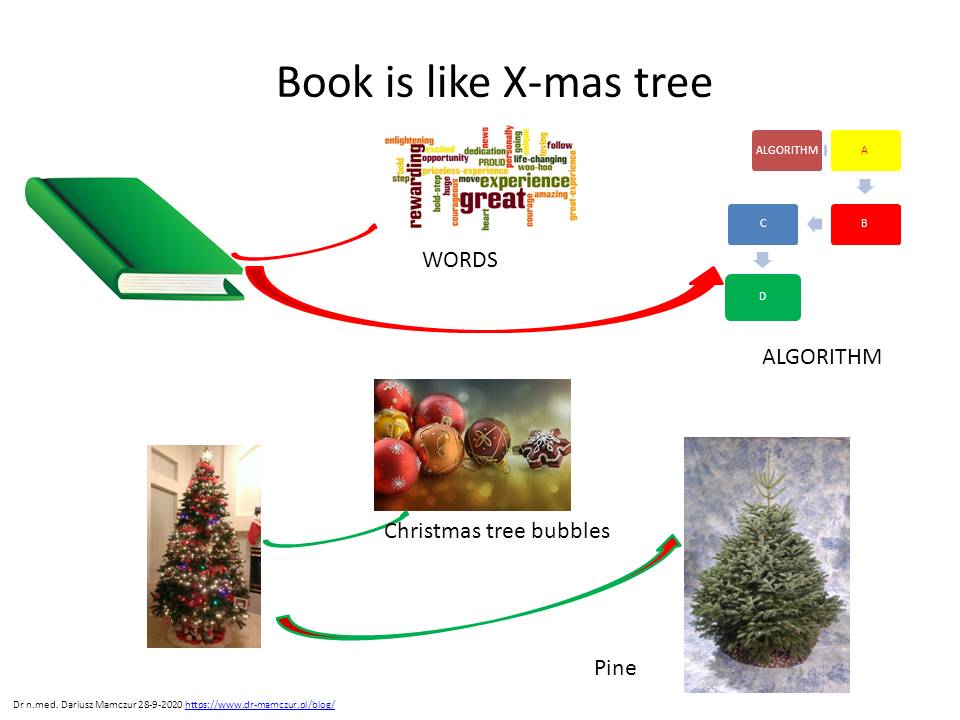

Ludzie muszą zmagać się z codziennymi problemami i chcą realizować swoje marzenia.(od tego rysunku się zaczęło w 2011 roku- wszystko można narysować- 🙂

Wiele z tych problemów powtarza się i u każdego z nas. Nauczyliśmy się radzić sobie z nimi dzięki własnemu doświadczeniu (wystarczy raz się oparzyć ogniem – a pamięta się to na lata) , mądrości poprzednich pokoleń przekazywanych z ust rodziców dzieciom, nauczycieli uczniom. Z czasem rady zapisywano w książkach, potem na filmach i nagraniach, a ostatnio w Internecie.

Korzystanie z doświadczeń innych pozwala nam na unikanie ich błędów, ale także przyspiesza prawidłową realizację własnych celów. Dlaczego za każdym razem musimy wywarzać otwarte drzwi. Chcesz upiec dobre ciasto – weź gotowy przepis.

Problem z przepisami jest taki, że jest ich wiele i nie są skatalogowane hierarchicznie i pod kątem ich przydatności. Nie zawsze wiemy skąd się wziął pomysł na takie, a nie inne rozwiązanie.

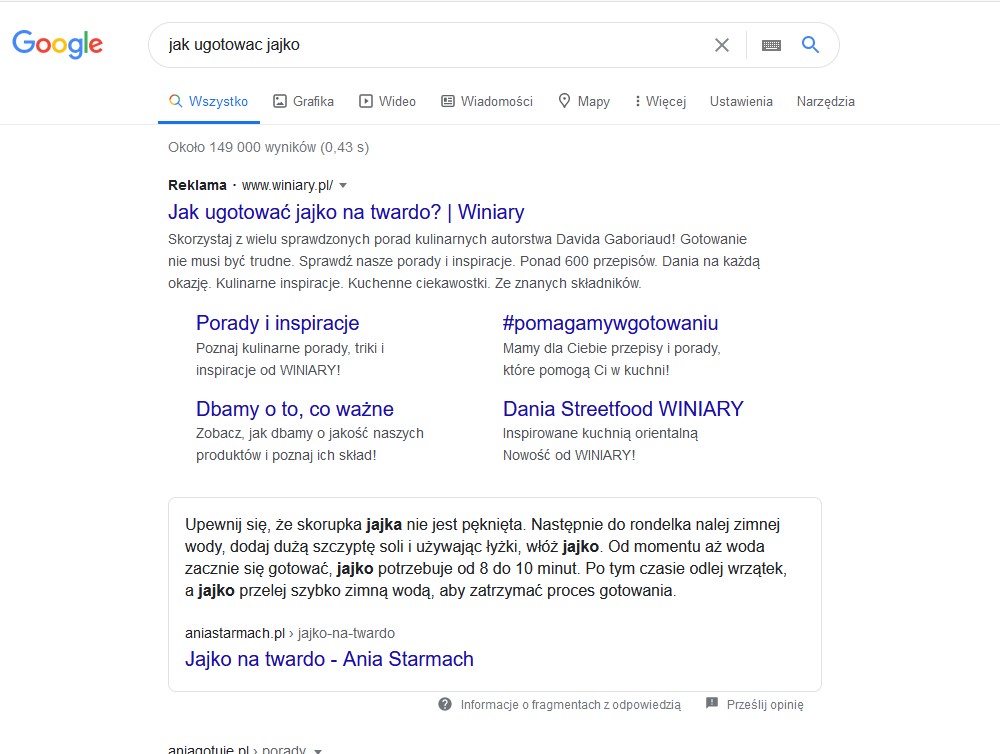

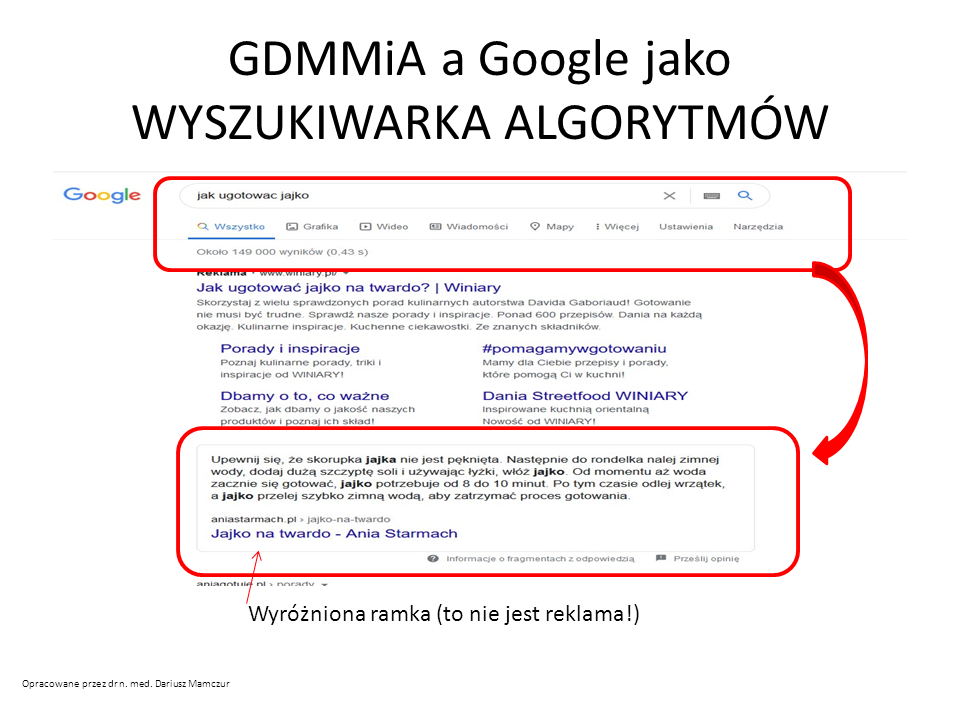

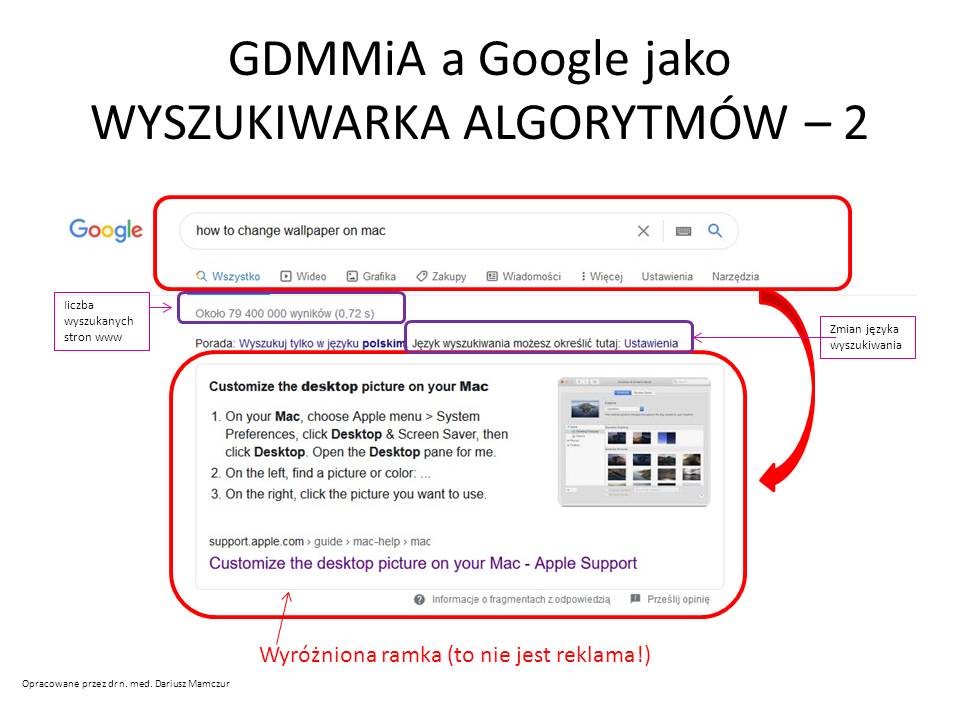

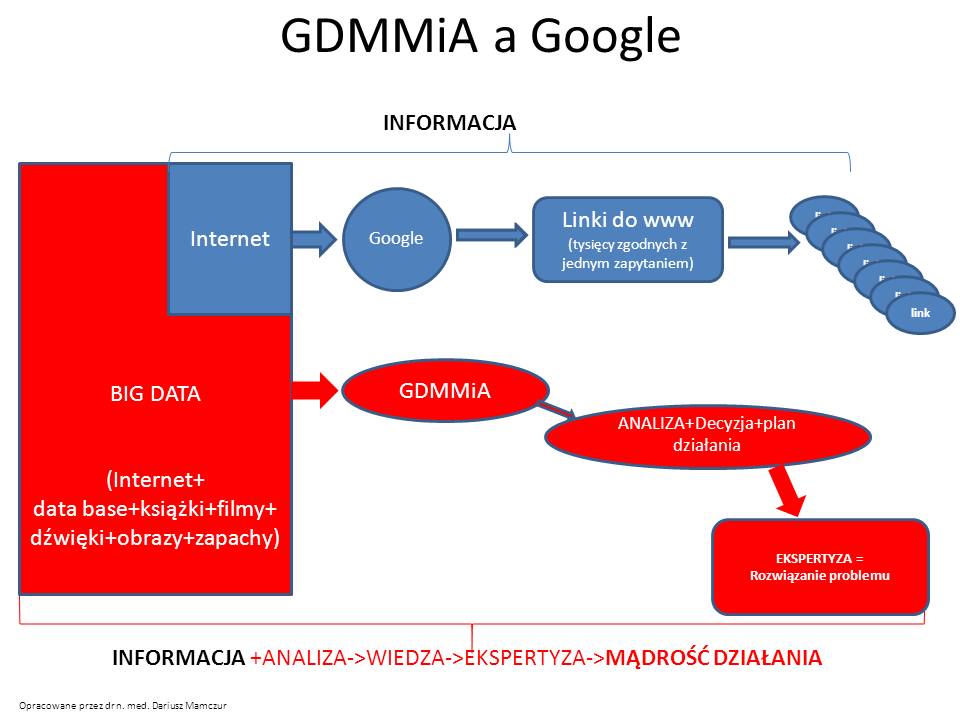

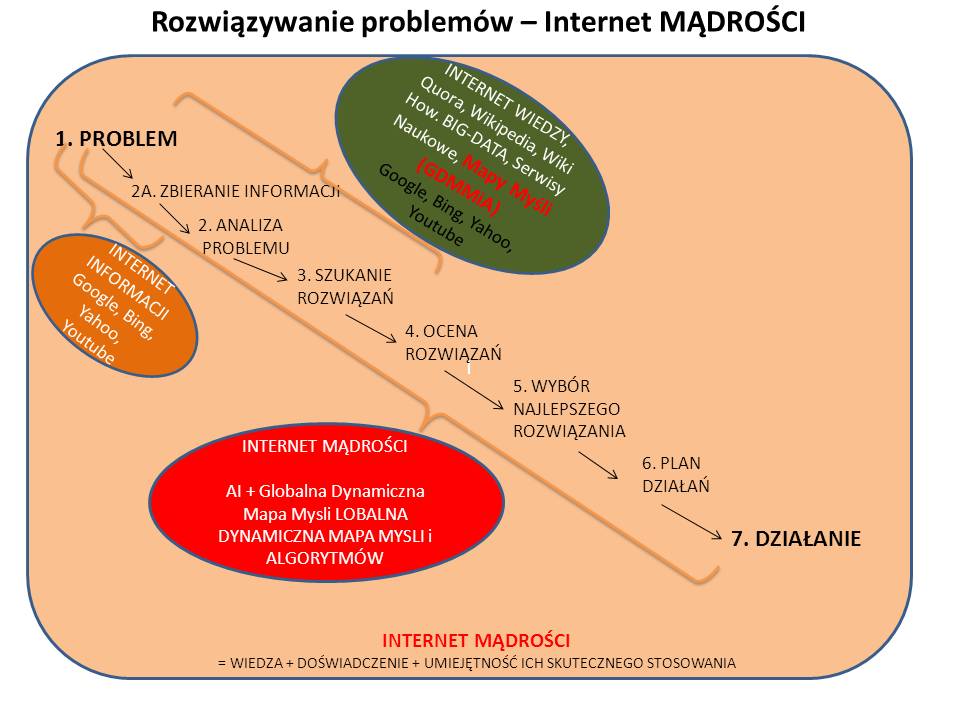

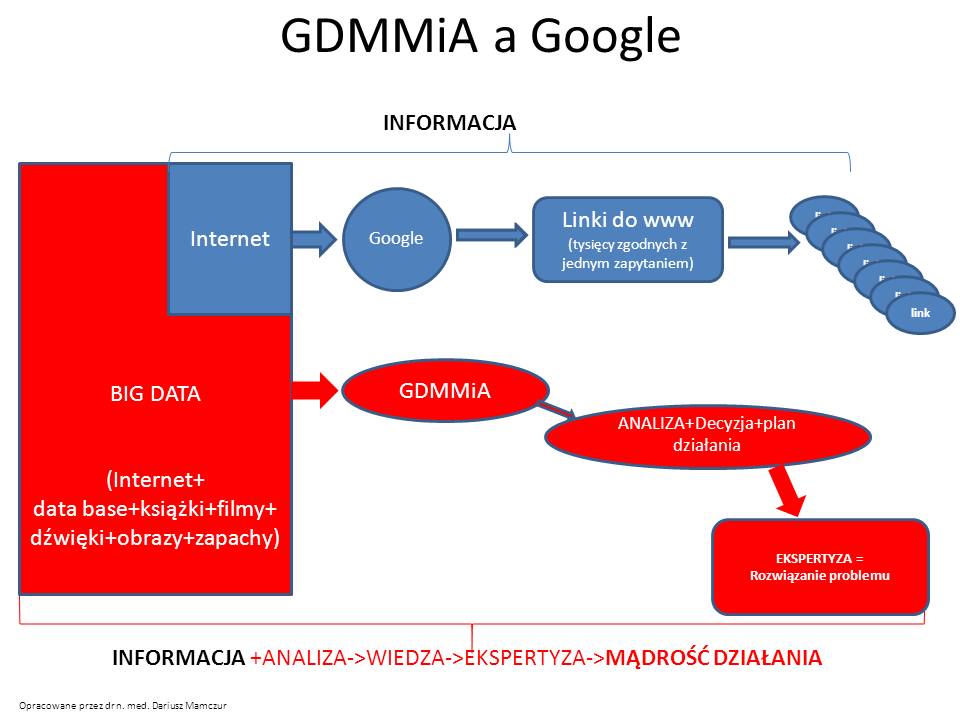

Google pozwala nam wyszukać tylko informacje znajdujące się na stronach www zawierających informacje zgadzające się z naszym zapytaniem (robi to coraz lepiej).

Cas potrzebny na analizę informacji i ilość odpowiedzi jest nadal przytłaczająca dla pytającego. Niestety, są to tylko INFORMACJE.

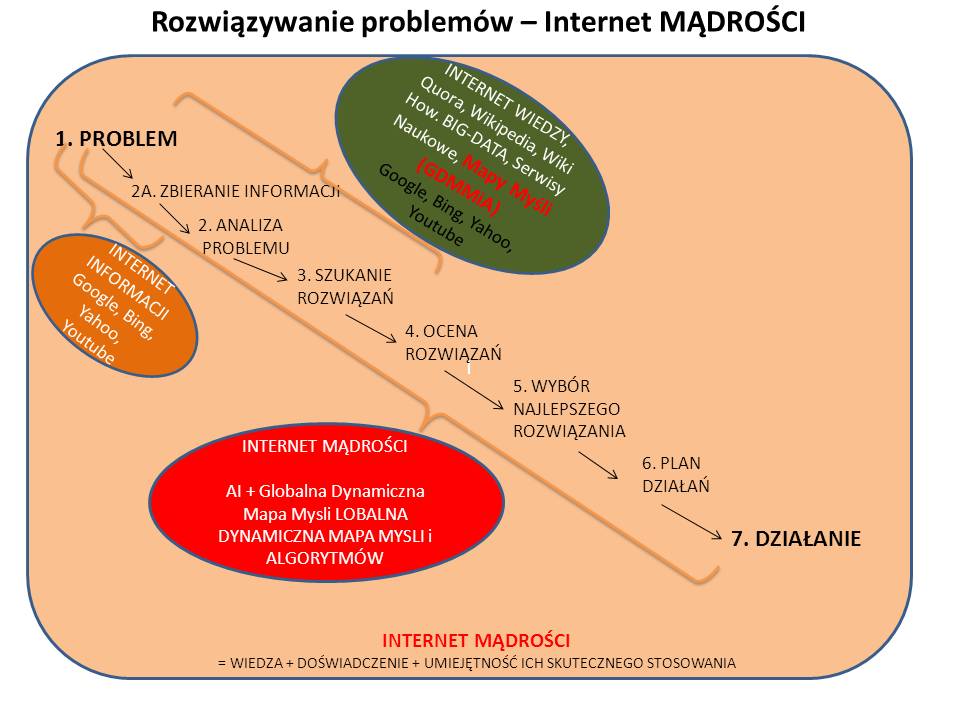

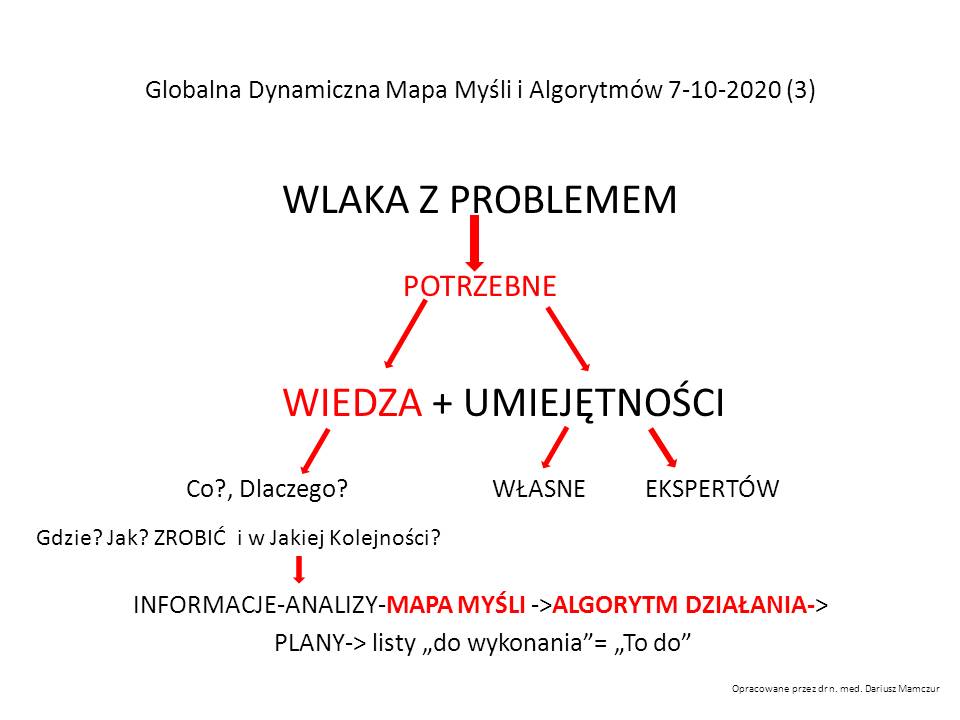

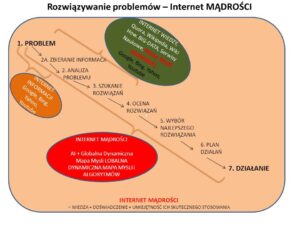

Jeśli chcemy rozwiązać problem, zmienić coś w życiu, osiągnąć swoje cele, to nie wystarczy wiedzieć COŚ? Trzeba wiedzieć DLACZEGO i W JAKI SPOSÓB?

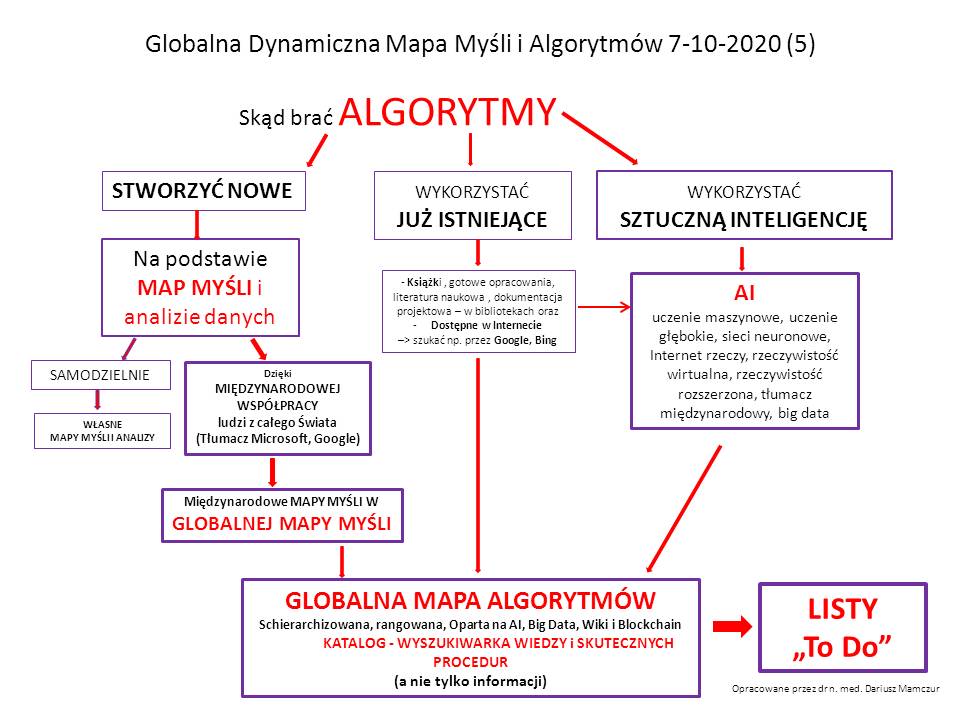

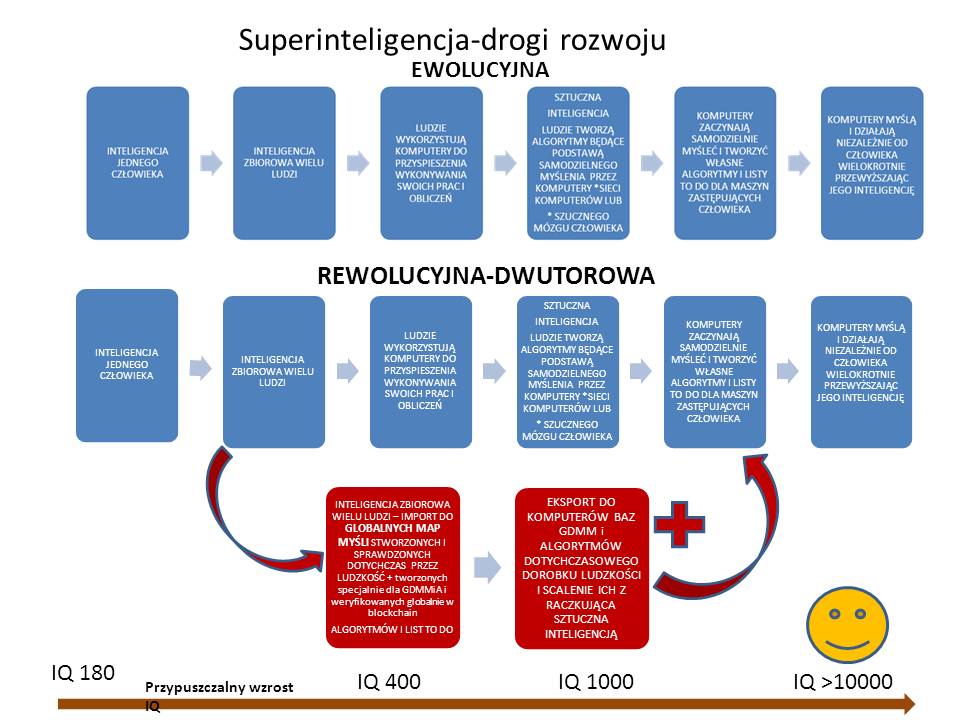

Trudno jest wyszukiwać stare rozwiązania (szczególnie czasopismach i książkach nie wspominając o filmach) i dołączać je w prosty sposób do nowych przepisów. Przy natłoku wiedzy i raczkującej sztucznej inteligencji potrzebne jest nam narzędzie, które pozwoli natychmiastowe generowanie najlepszych rozwiązań problemów, według najbardziej aktualnej informacji, dostępne od ręki w ciągu kilku sekund.

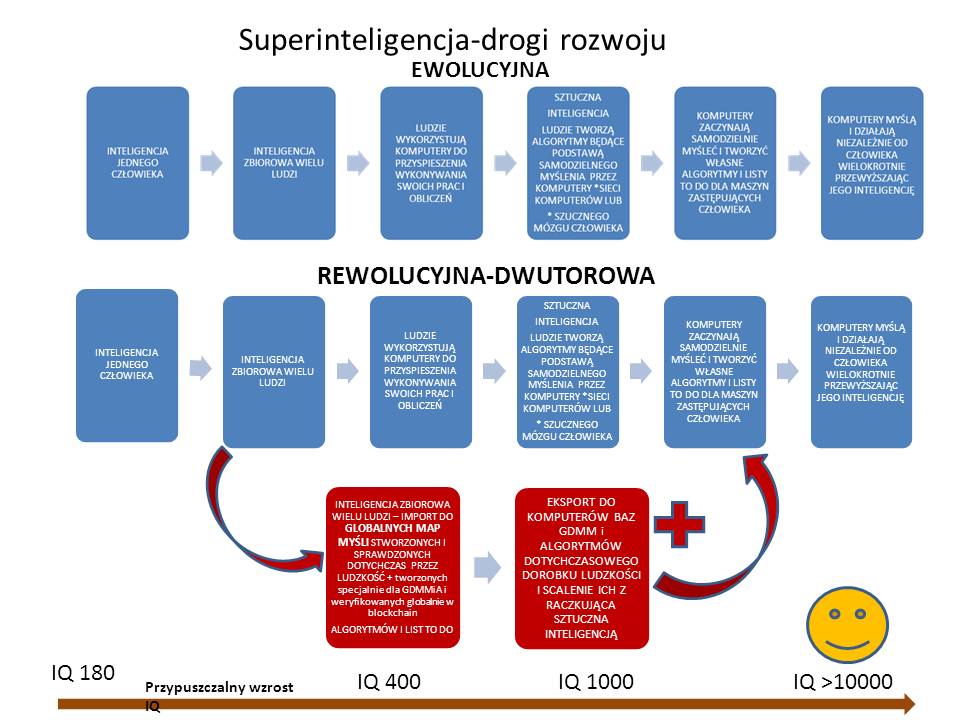

Narzędziem takim może być sztuczna inteligencja, która po przeanalizowaniu dostępnych w całym Internecie baz danych wyciągnie z nich wnioski i stworzy algorytm pozwalający ustalić czynności i ich kolejność, aby zrealizować projekt lub rozwiązać problem.

Niestety z czasem stracimy kontrolę nad algorytmami sztucznej inteligencji, możemy się stać społeczeństwem bezwolnych analfabetów poddanych nadzorowi “wielkiego brata”.

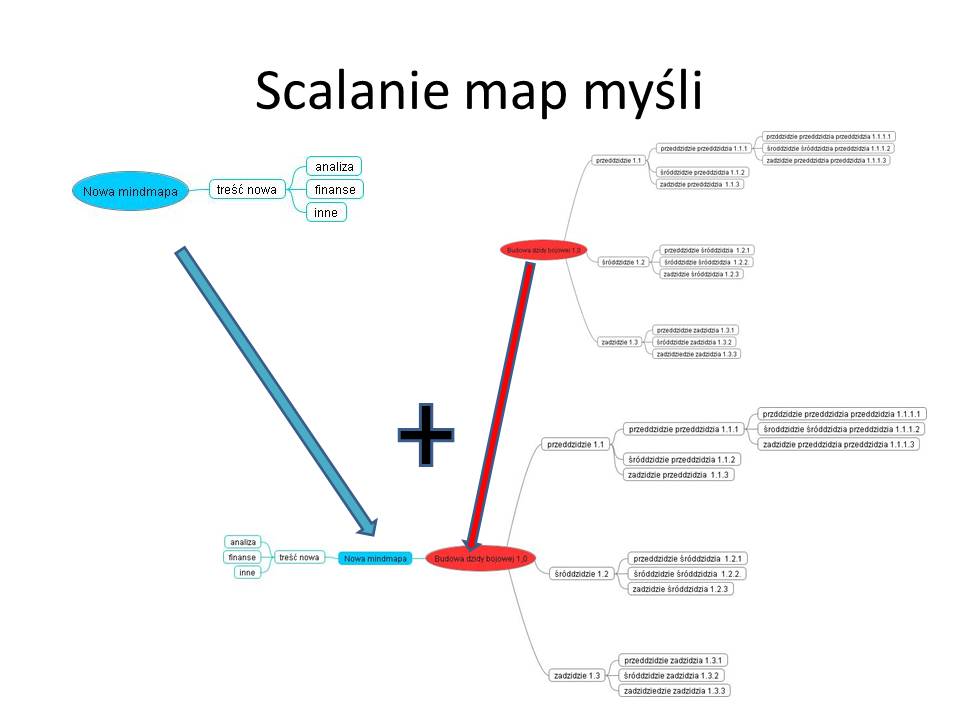

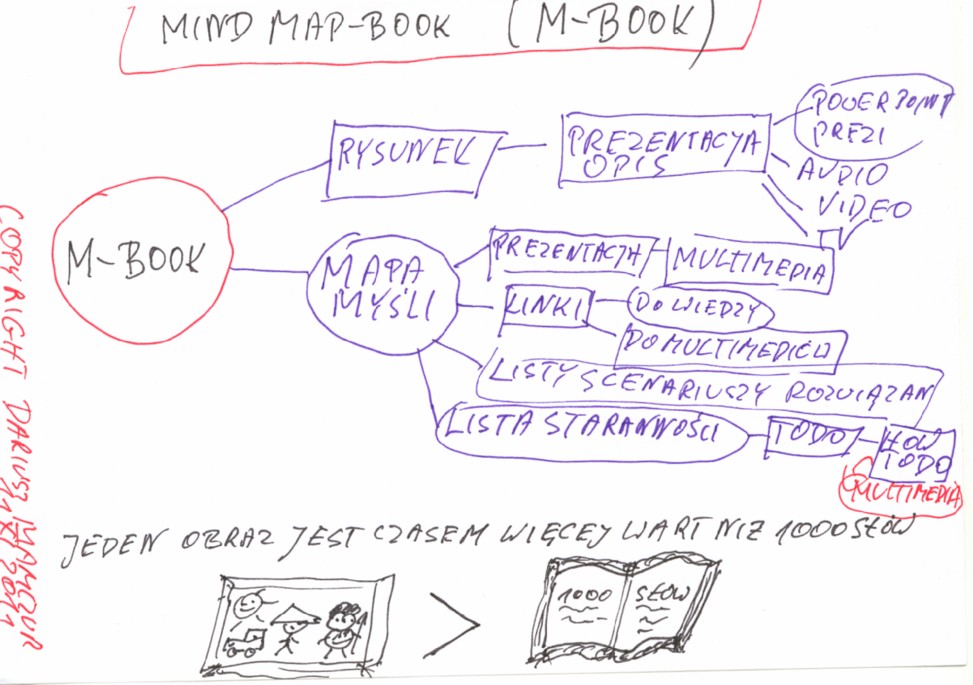

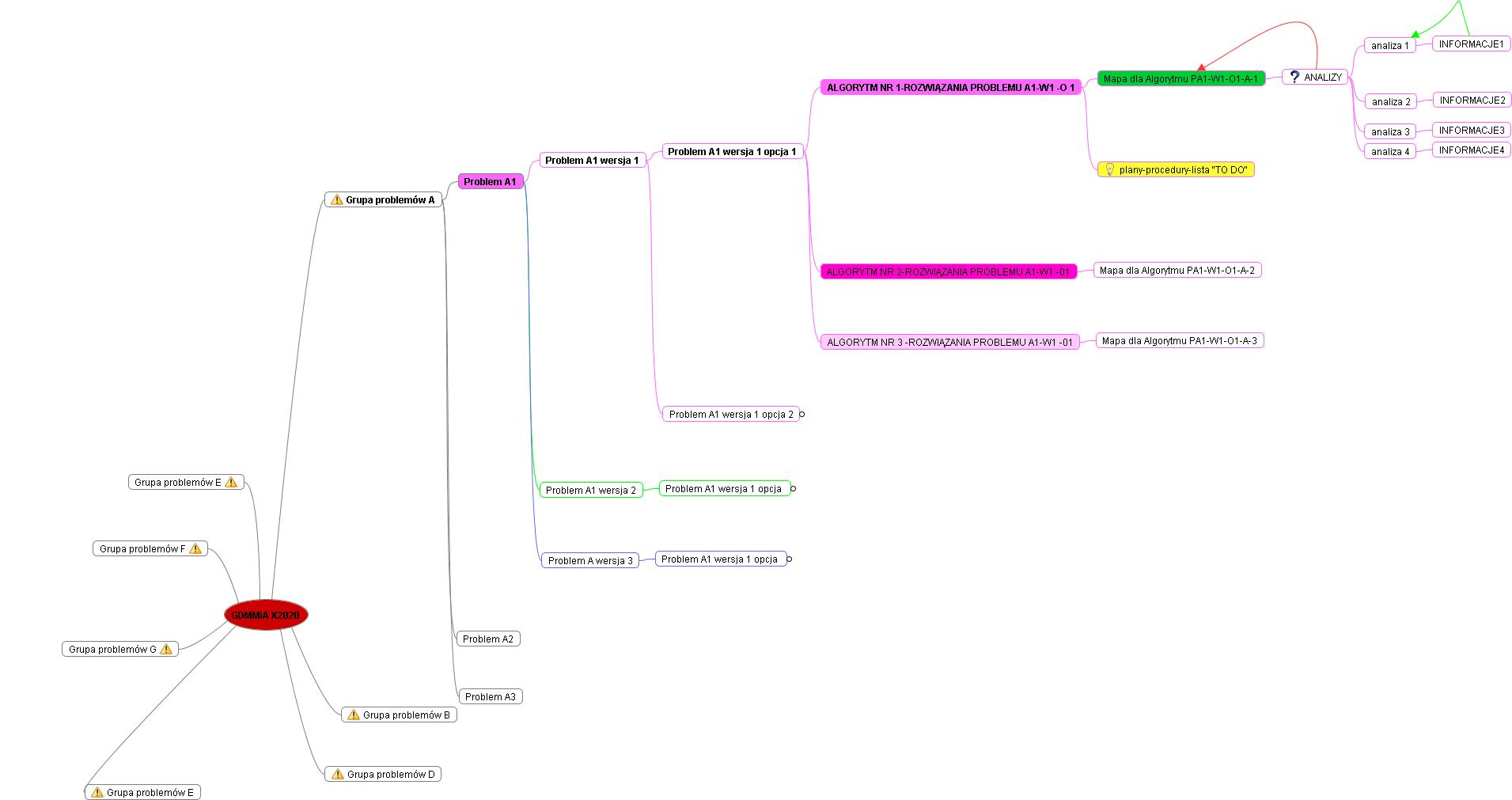

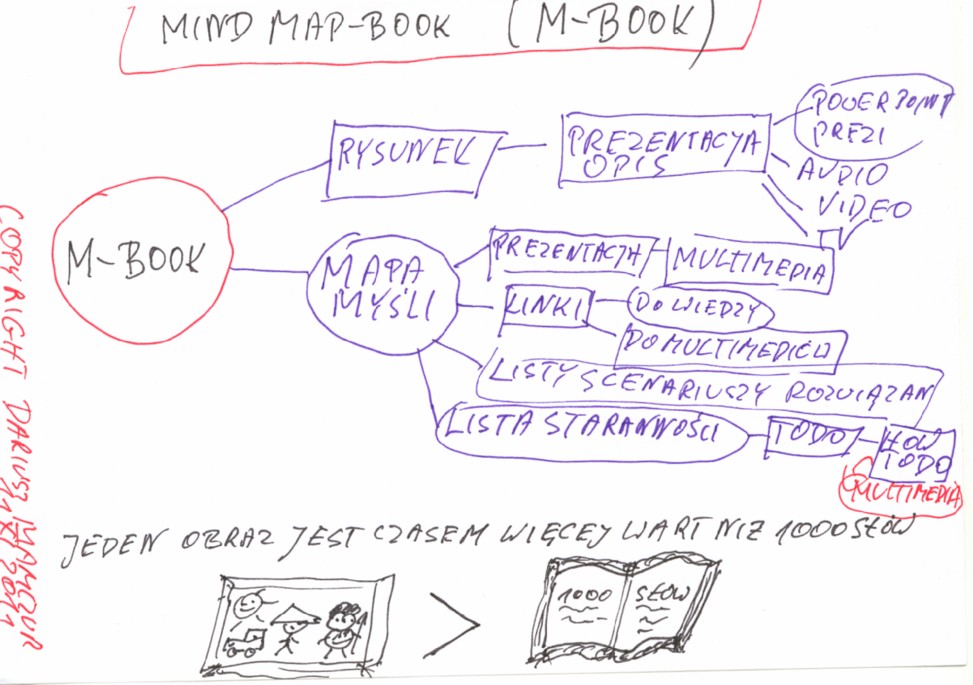

Dla tych rozwiązań przydatne może być stworzenie inteligentnego narzędzia, które będzie wspomagało tworzenie sztucznej inteligencji (będzie jej dostarczał ludzkich algorytmów). Narzędzie to do momentu, gdy AI stanie się faktem, pozwoli także na równoległe skatalogowanie i ciągłe aktualizowanie łatwo dostępnej wiedzy. Tworzone przez ludzi świadomych, kreatywnych będzie zawierało zrozumiałe dla nas algorytmy rozwiązywania wszystkich naszych problemów. Jak to zrobić? Na chwilę obecną uważam, że cyfrowe mapy myśli spełniają najwięcej wymogów, jakie można sobie postawić w takim projekcie.

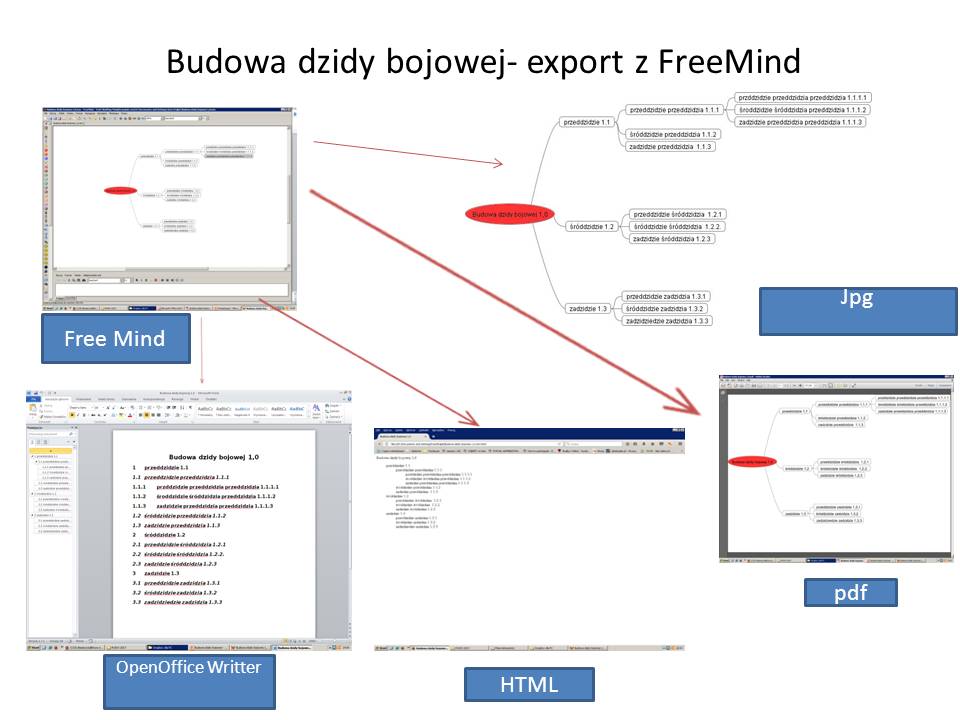

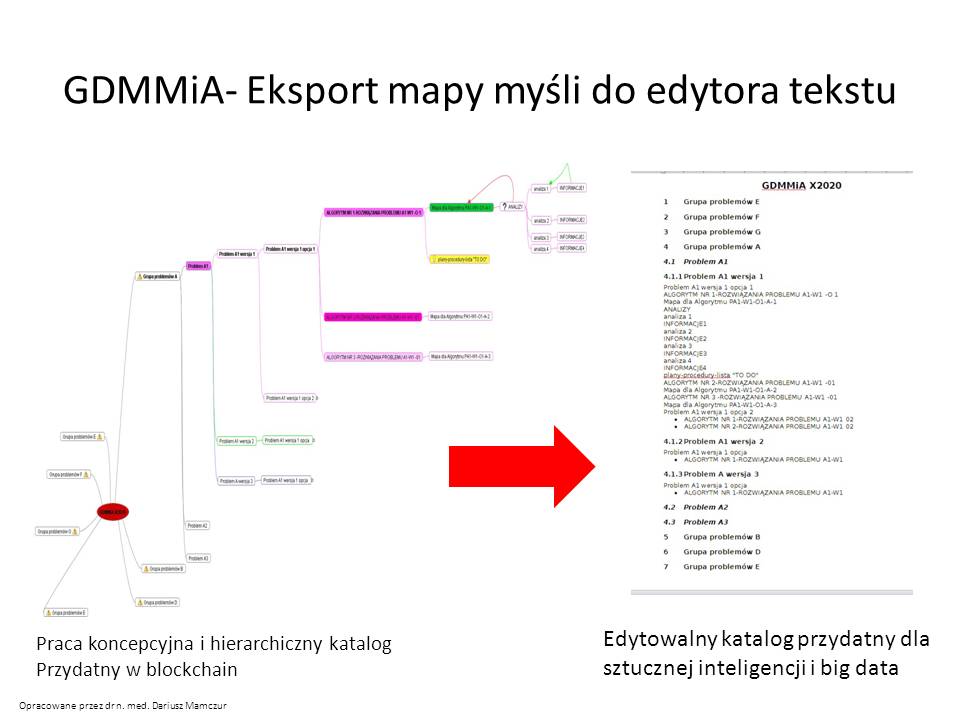

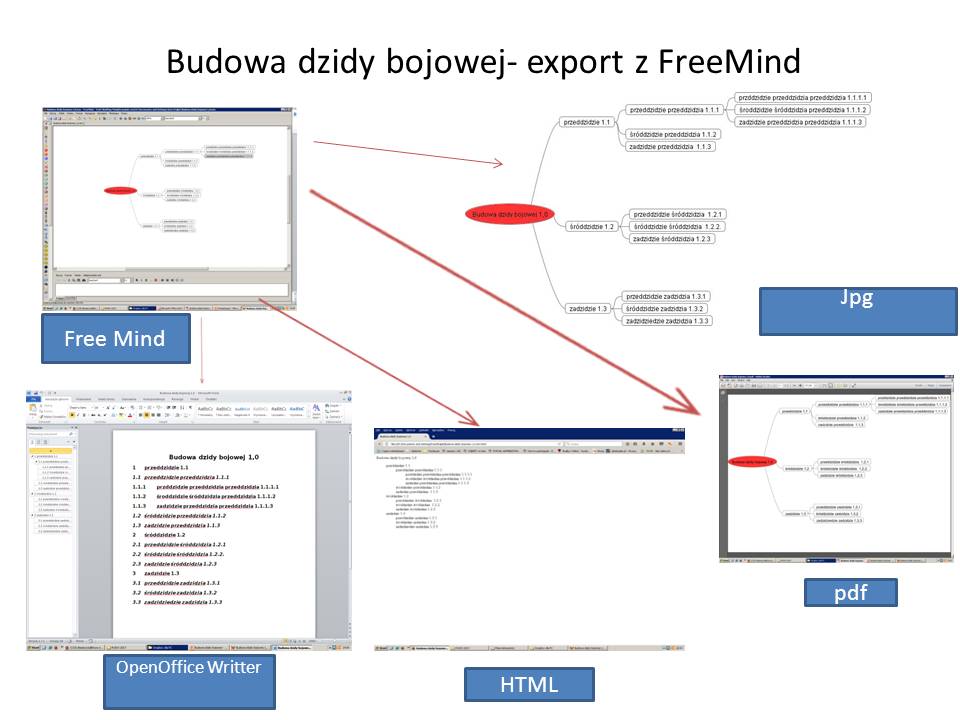

Mapy myśli pozwalają analizować problem, gromadzić linki lub informacje potrzebne do rozwiązań, tworzyć strategie, dołączać algorytmy lub pliki a algorytmami, można je eksportować do plików pdf, html, jpg, word.

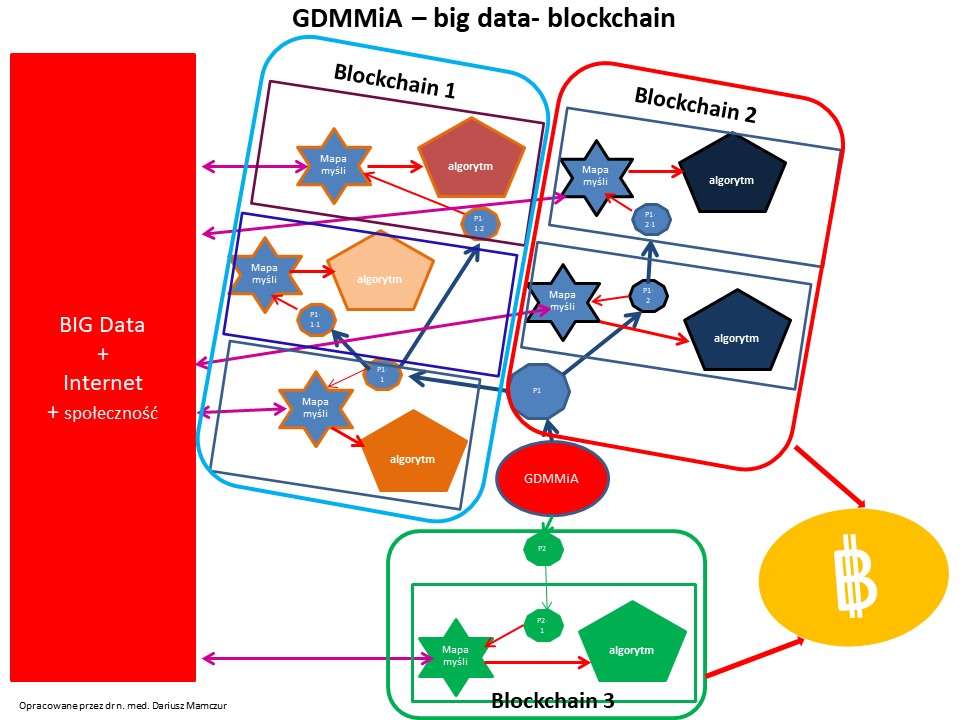

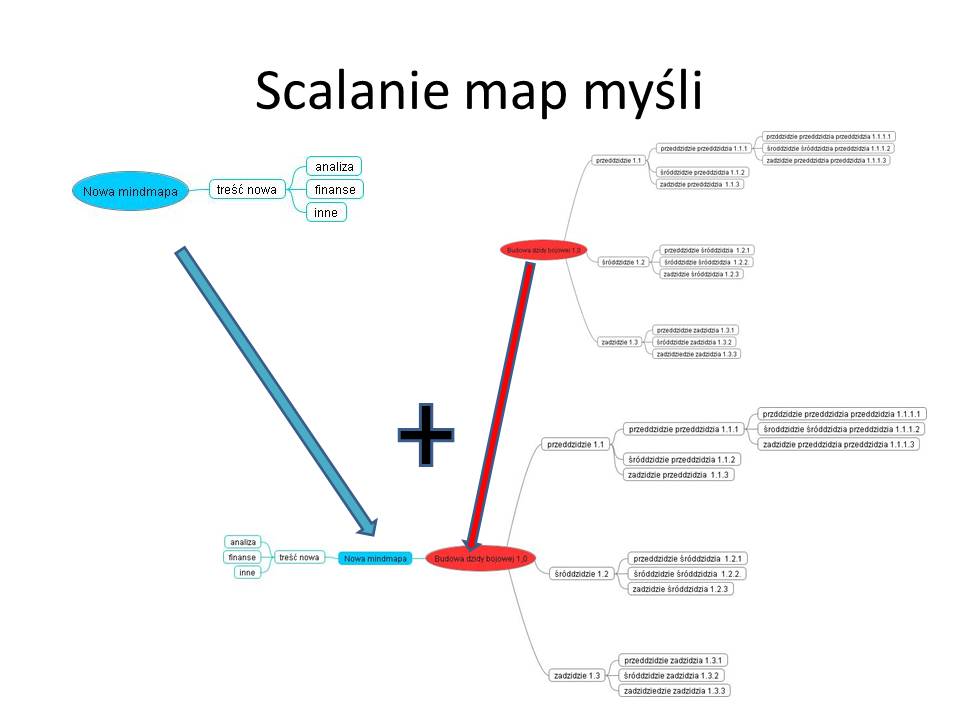

Mapy myśli, a szczególnie ALGORYTMY dają szansę łatwej weryfikacji oryginalności rozwiązania (czy ktoś nie powiela tego samego pomysłu innymi słowami). Narzędzie potrzebuje niewiele treści pisanej (szybki zapoznanie się z treścią), bazy danych można przechowywać poza mapami myśli, dlatego też nie są one zbyt “danochłonne”, łatwo dołączać do mapy centralnej pojedyncze mapy dotyczące kompleksowych rozwiązań (ale mniejszych zagadnień – klocki te nazywam to “cegiełkami” mapy). Można mapę budować równocześnie przez społeczność na całym świecie (podobnie jak WIKI). Międzynarodowy dostęp do narzędzia pozwala tworzyć GLOBALNE rozwiązanie informatyczne.Do ustalenia pozostanie, czy ze względów technicznych powinna to być mapa myśli zawierająca algorytmy, czy będą to dwie oddzielne, ale sprzężone ze sobą bazy danych

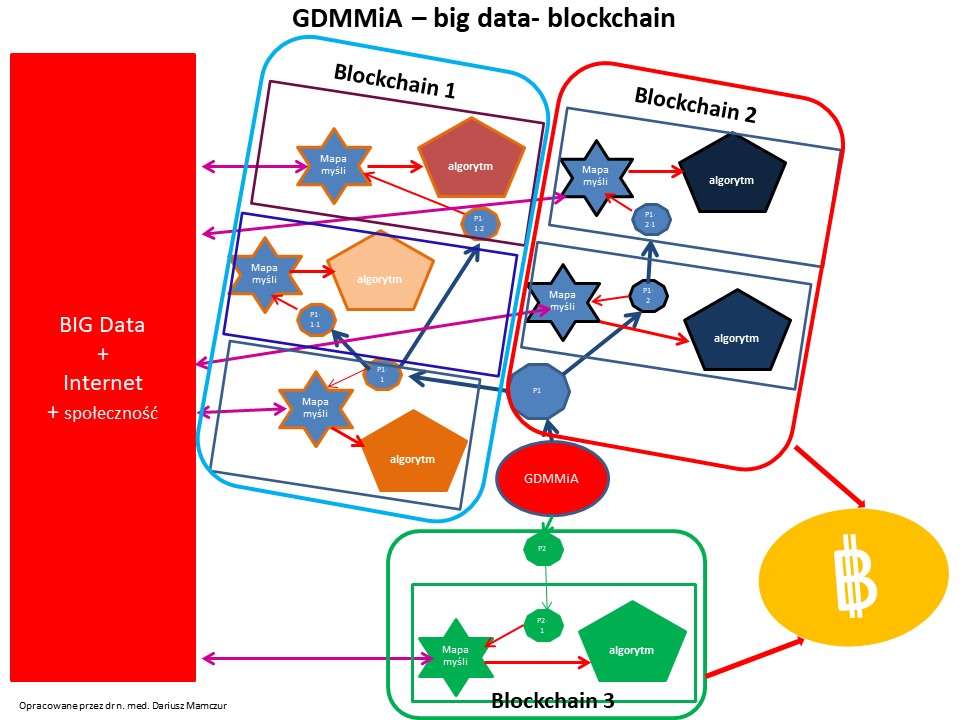

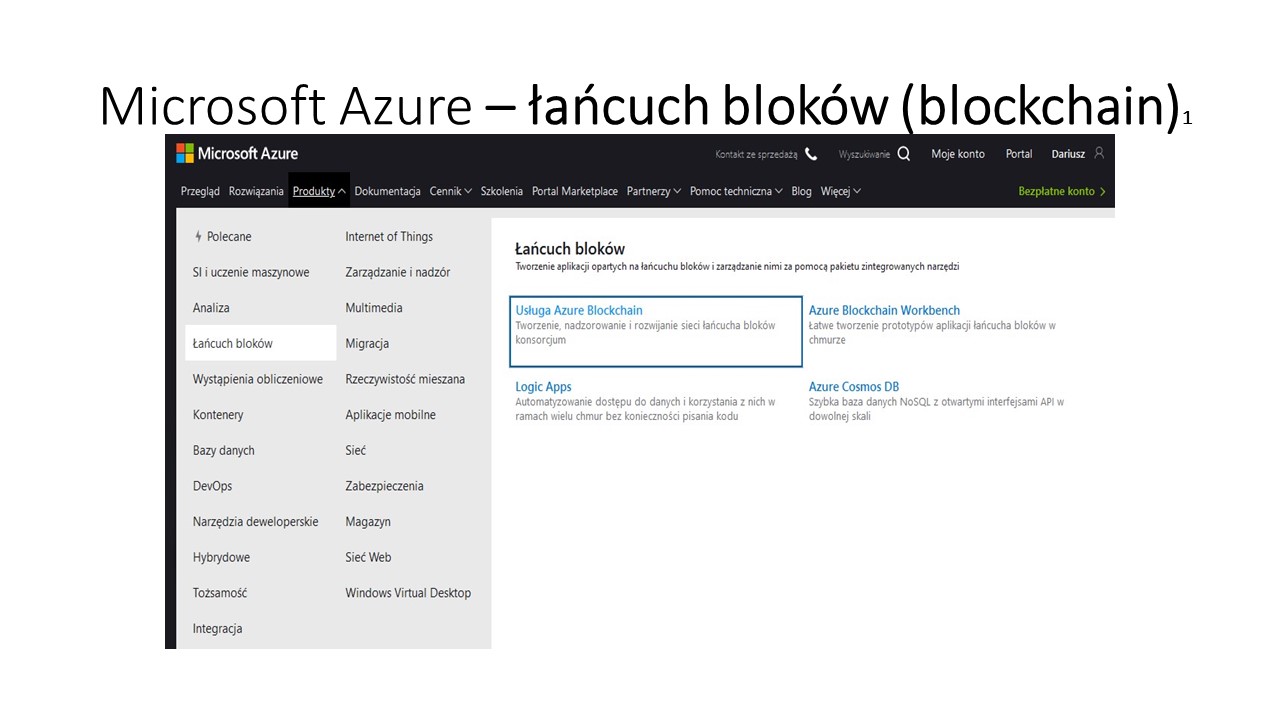

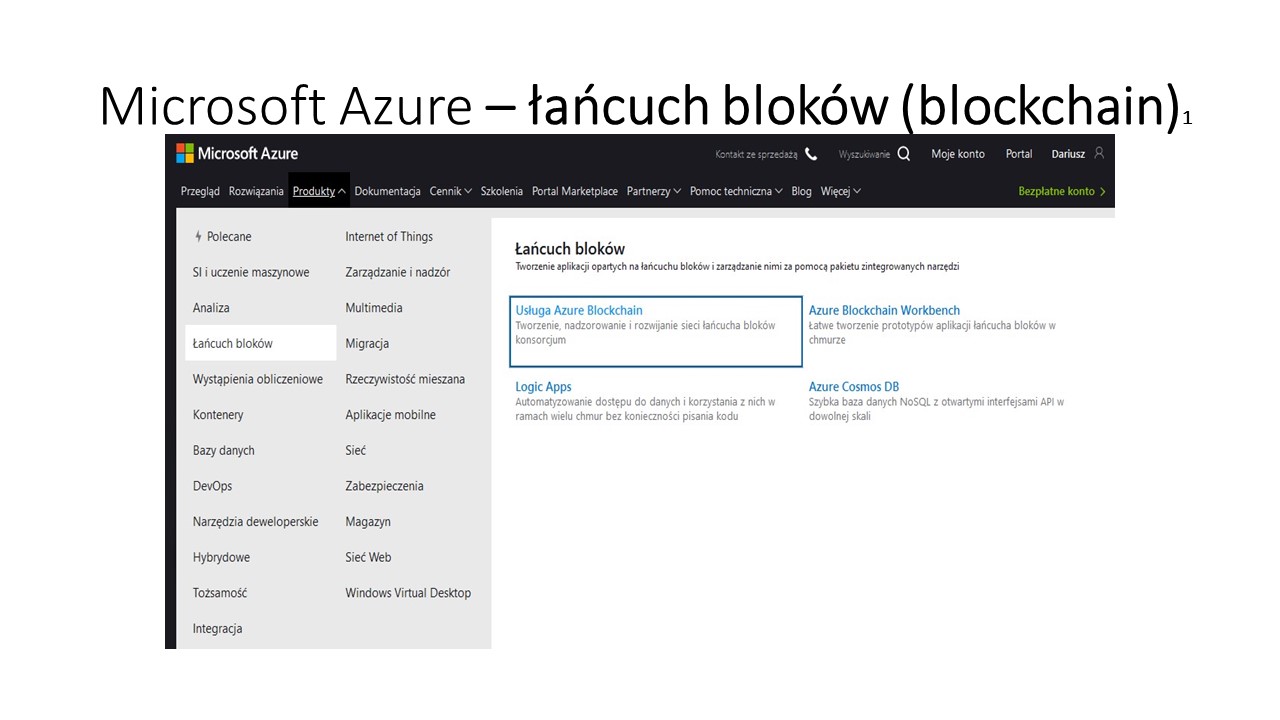

“Cegiełkowy” system budowy mapy umożliwia jej ciągłą aktualizację i rozwój, ale przede wszystkim na wykorzystanie w tej architekturze technologii blockchain , która zabezpieczy dane przed hakerami, ale też może zapewnić prawa autorskie, które można skomercjalizować. Uzyskane fundusze pozwolą na samofinansowanie się projektu, mogą też przynieść duże zyski właścicielom projektu. Poszczególne elementy mapy i dołączone do niej algorytmy można wykorzystać do pisania książek, tworzenia filmów, reklam, w edukacji biznesie (M-book Shop).

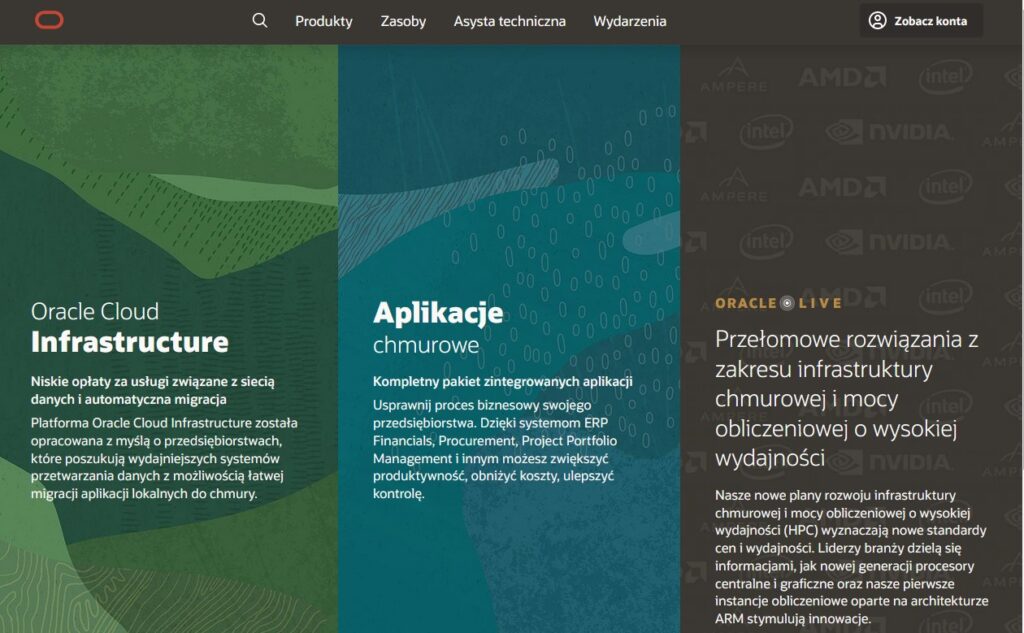

Gdzie przechowywać tak olbrzymie ilości danych. Może pomocna będzie bezpieczna chmura firmy Oracle i jej system blockchain.

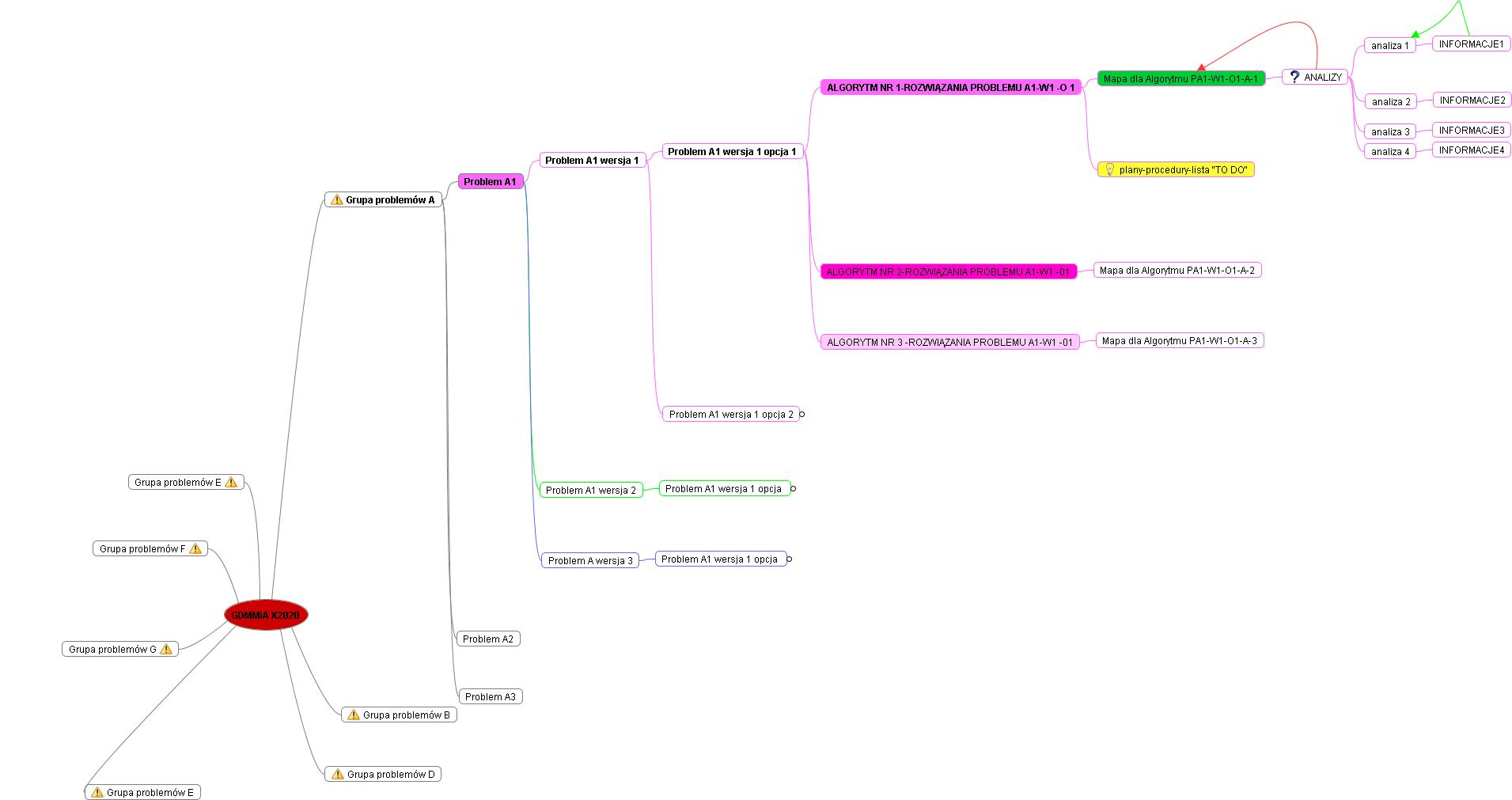

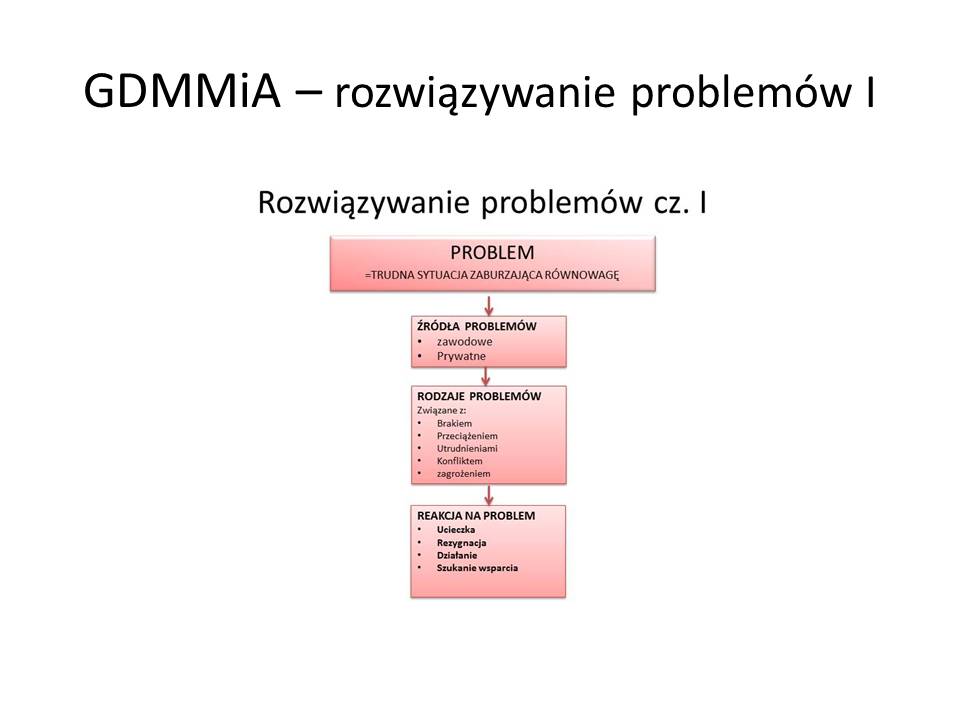

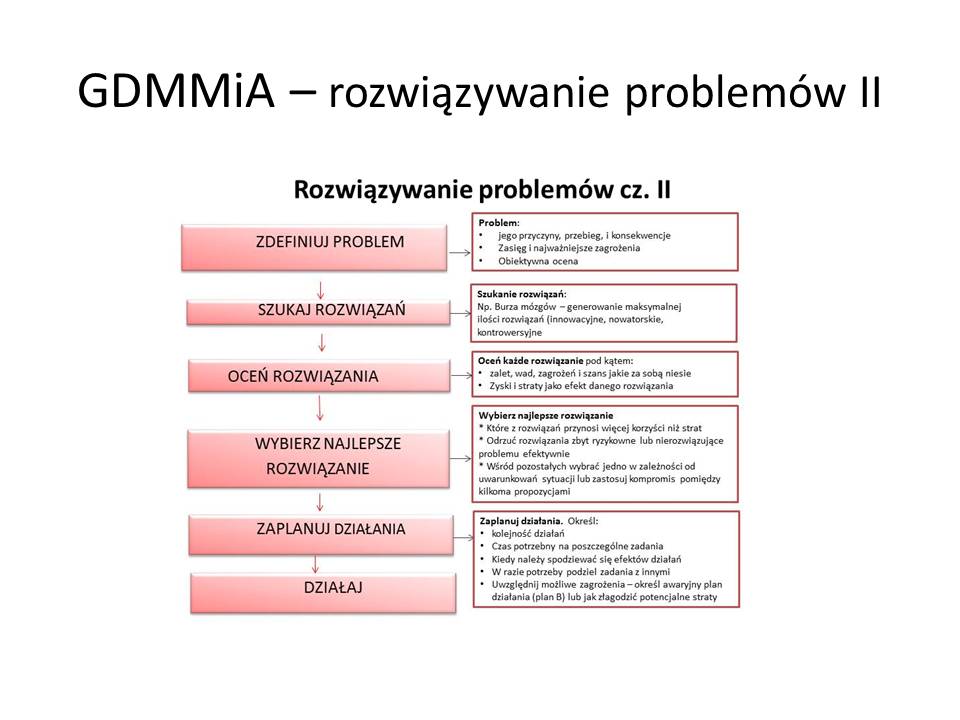

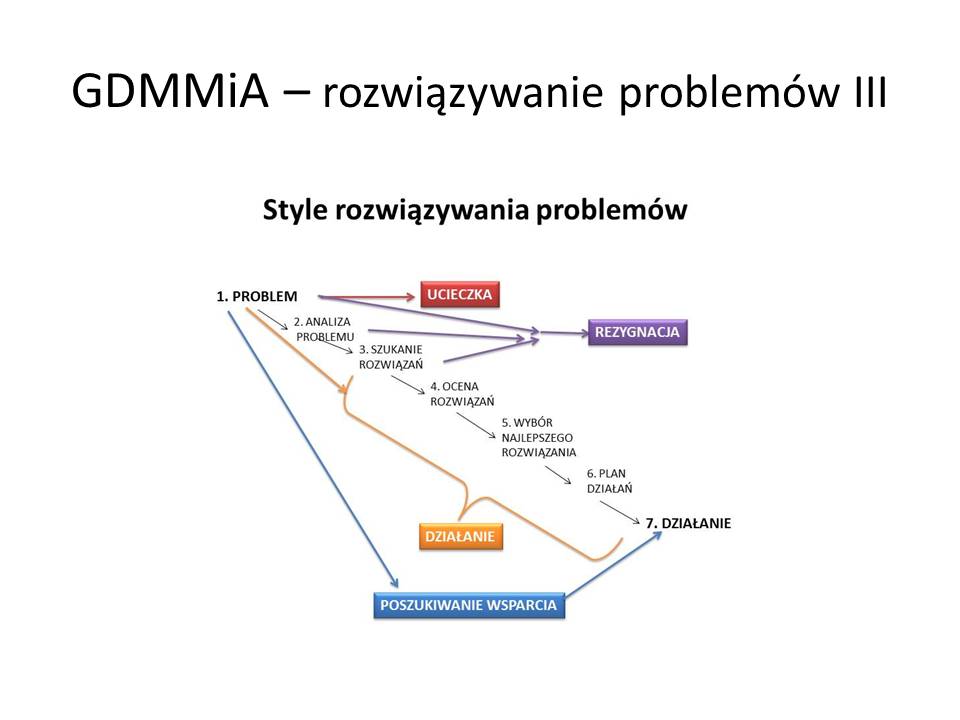

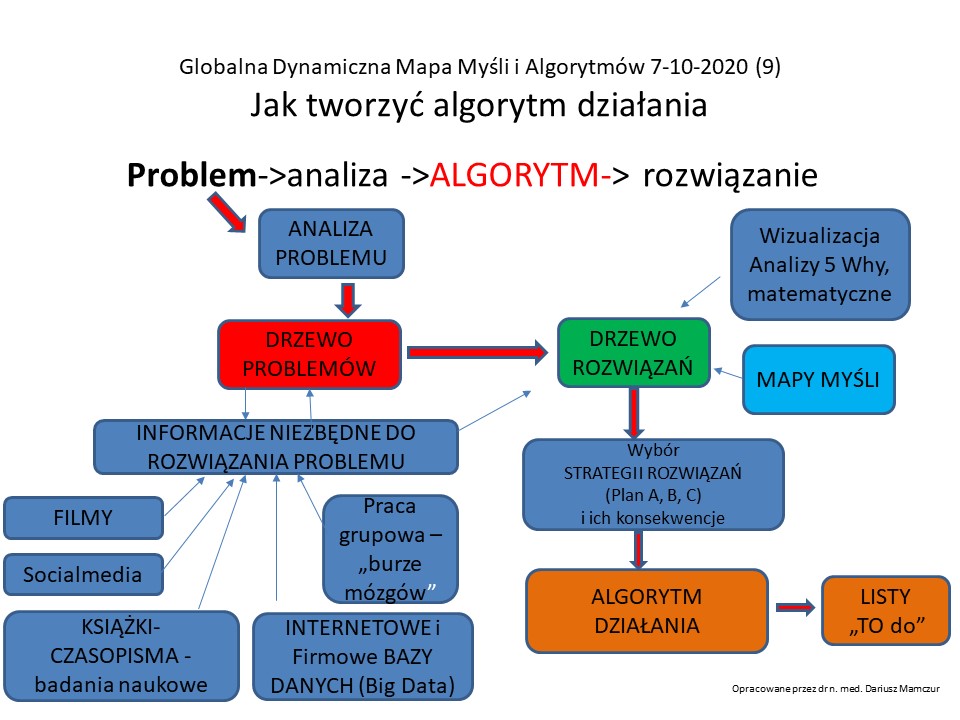

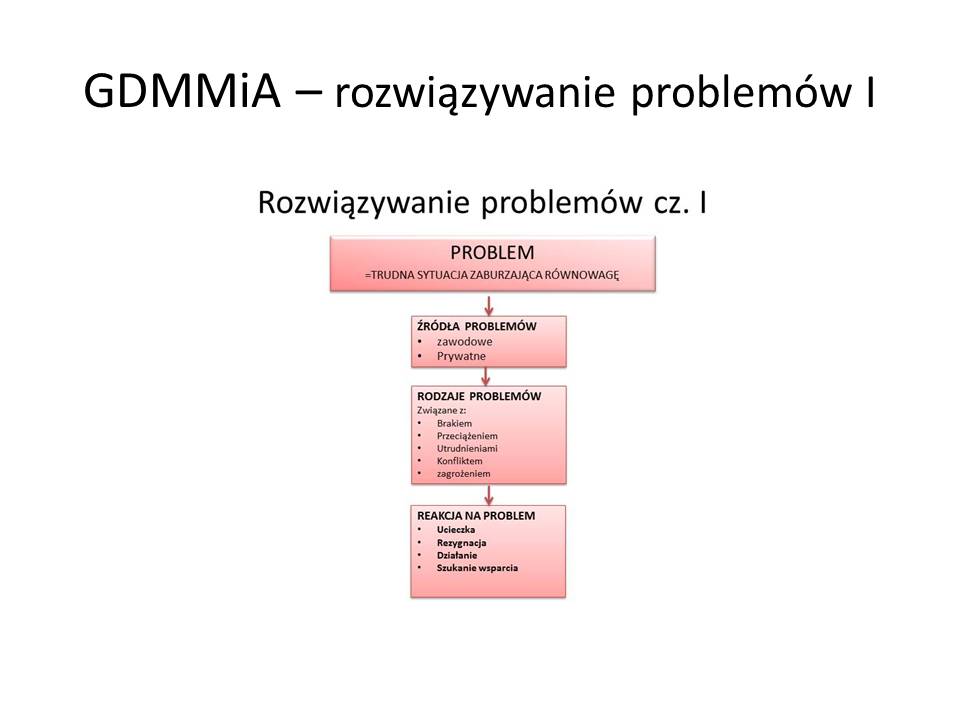

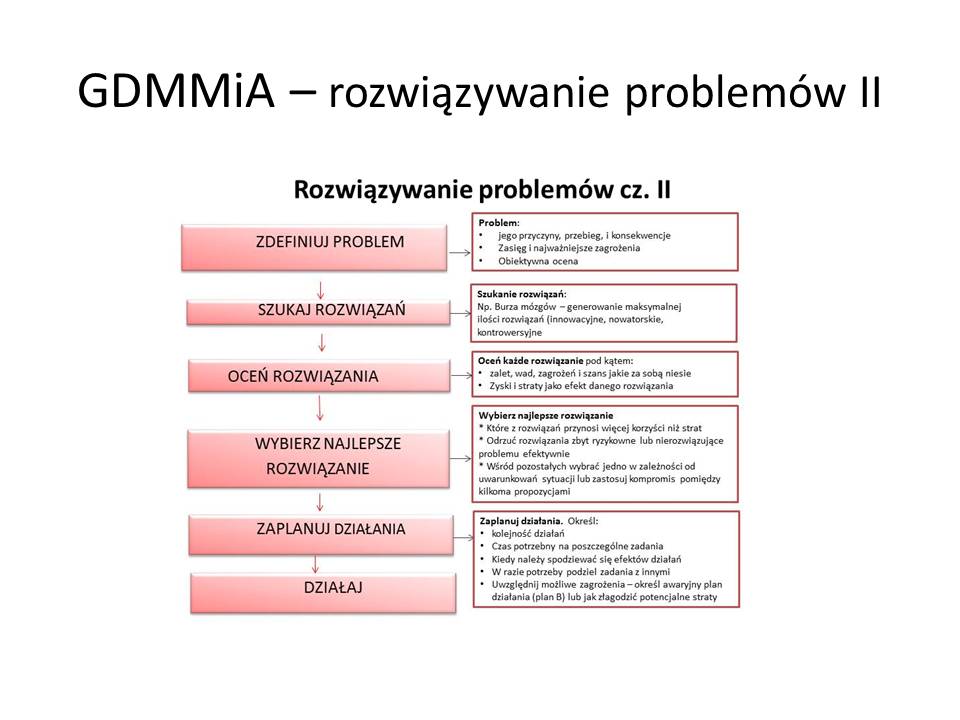

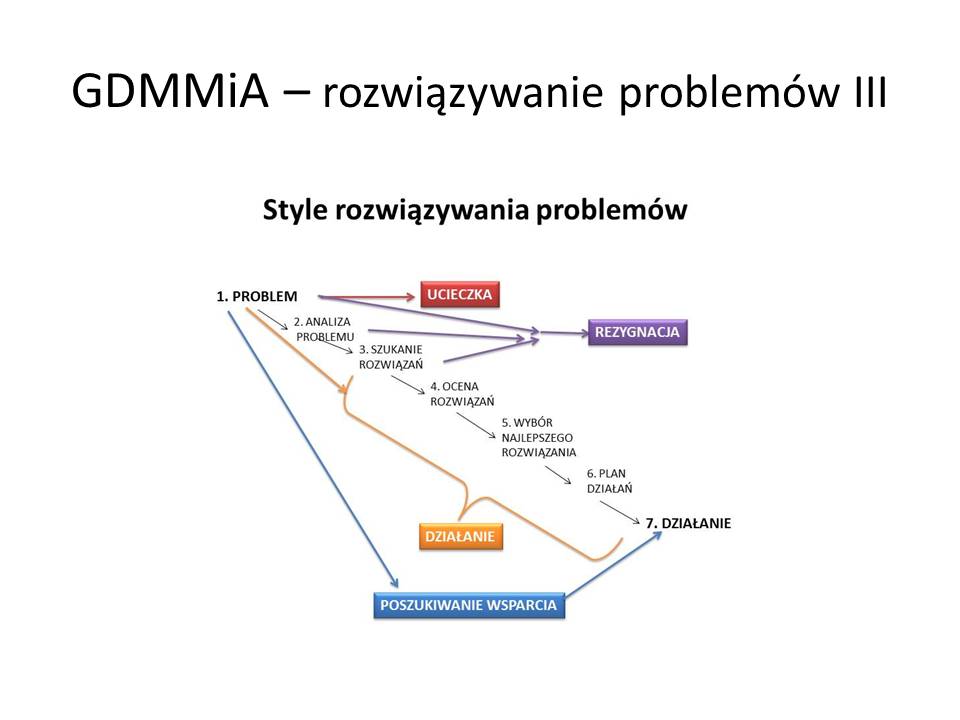

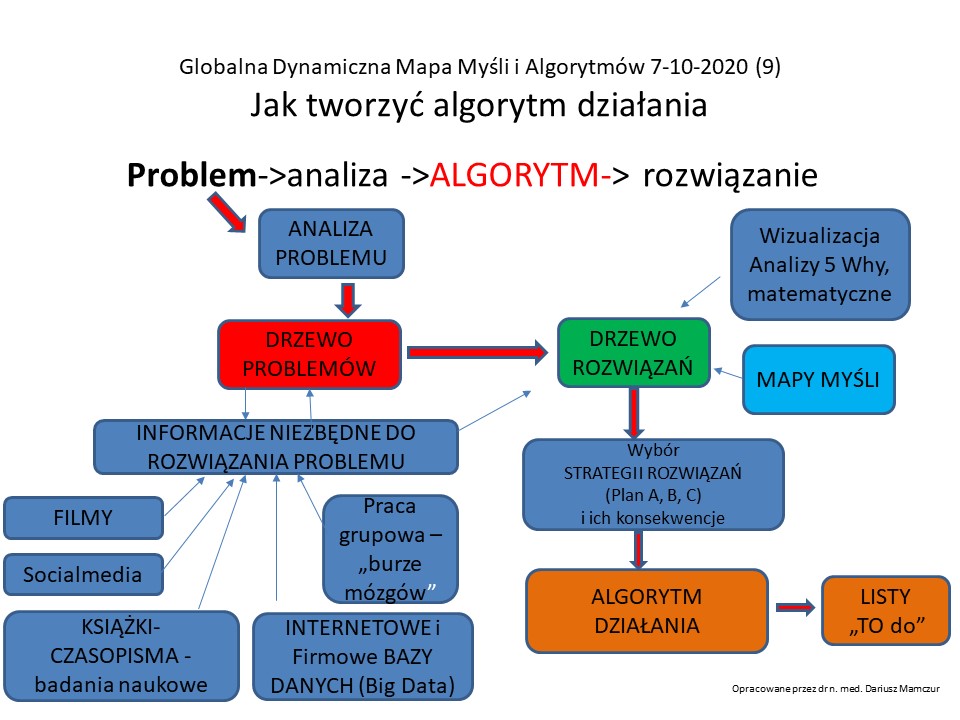

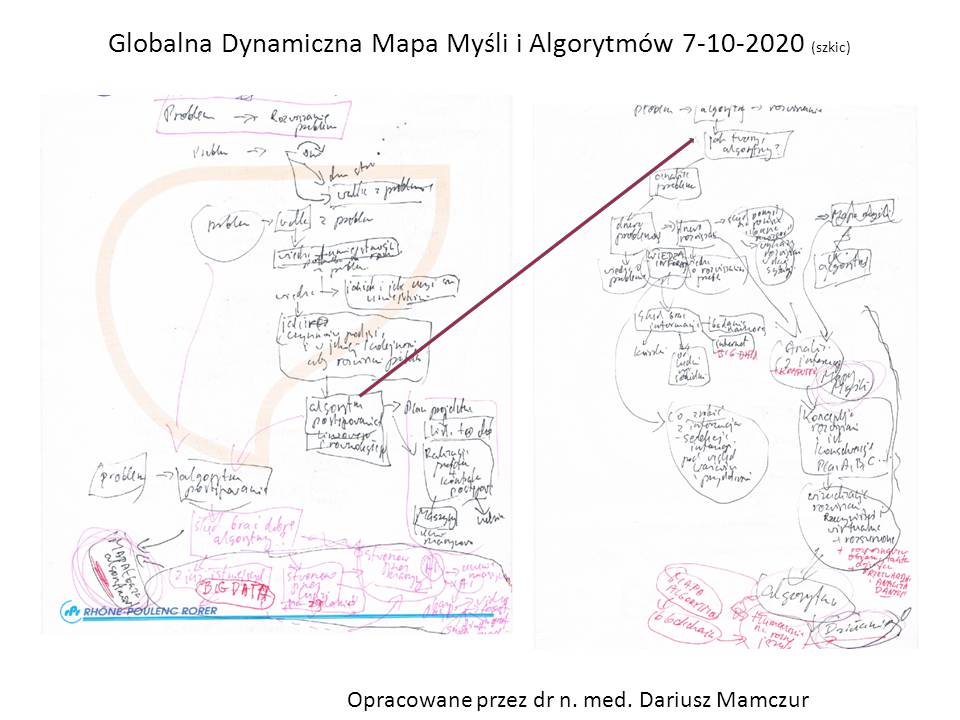

Procedura rozwiązywania problemów jest dość złożona

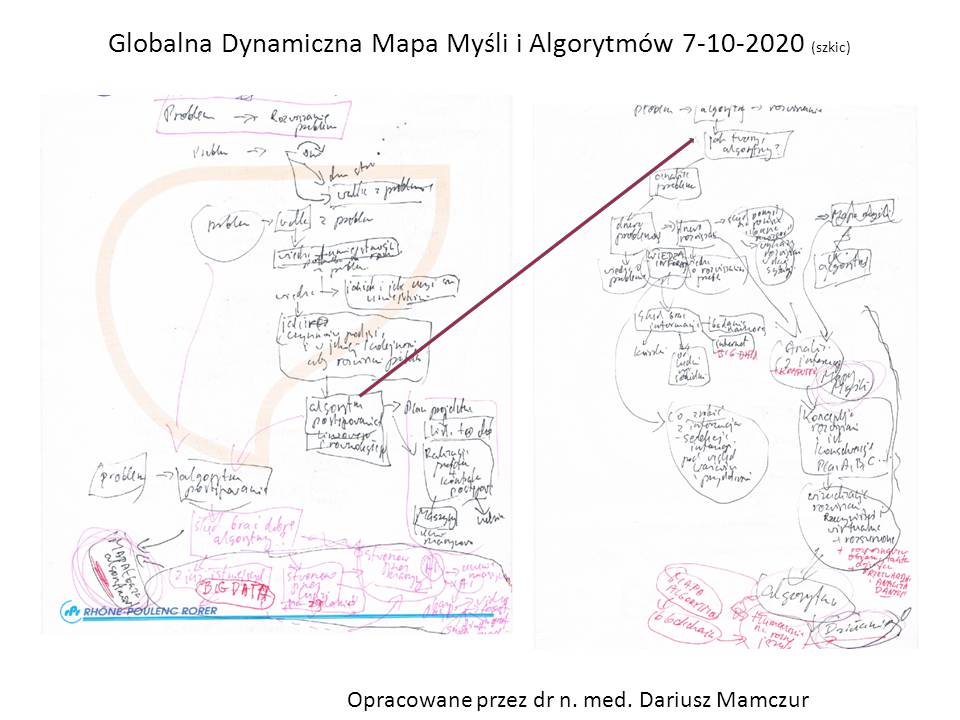

Tak wyglądała praca koncepcyjna nad tym pomysłem i wpisem. Myślenie koncepcyjne staram się zaczynać od końca, tj. od efektu jaki chcę osiągnąć, a potem szukam prawidłowości i możliwych planów realizacji.

Zaczynamy:

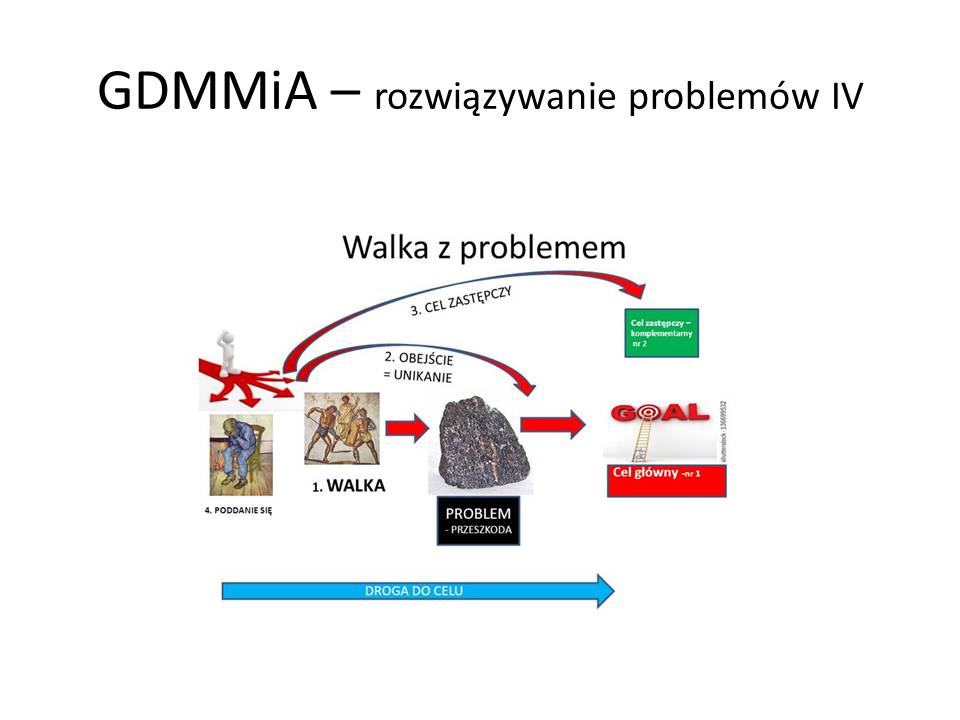

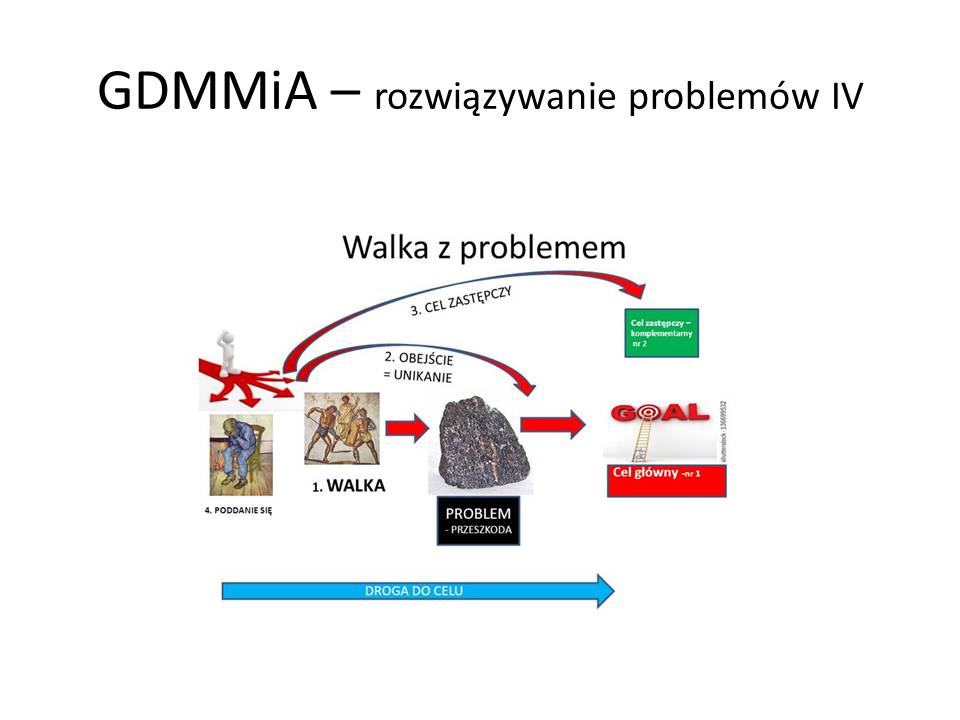

W GDMMiA wybieram walkę z problemem

W GDMMiA wybieram walkę z problemem

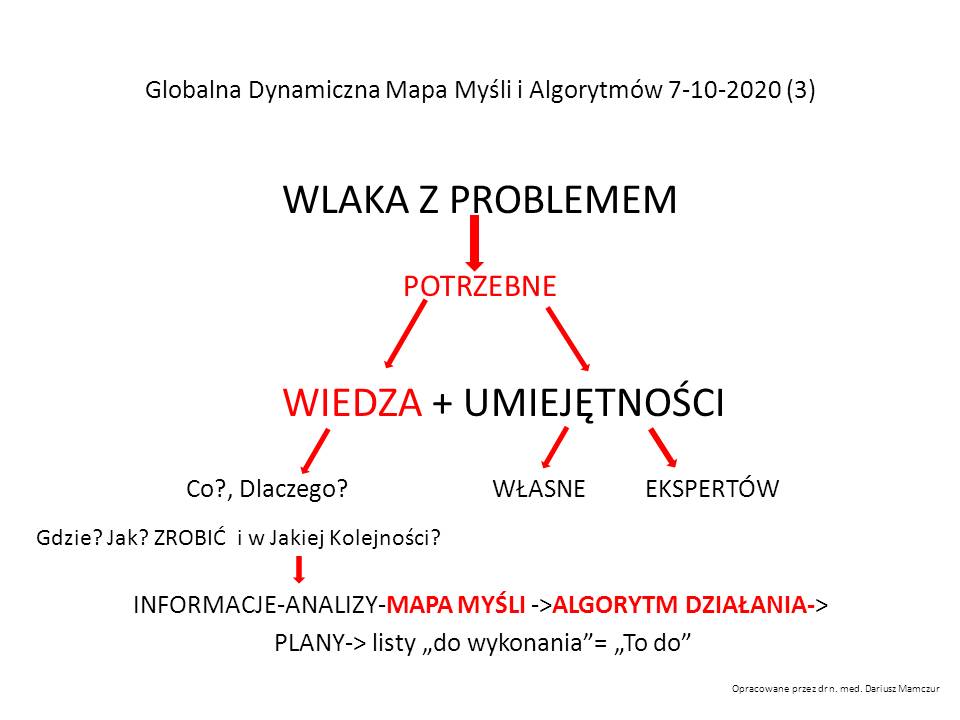

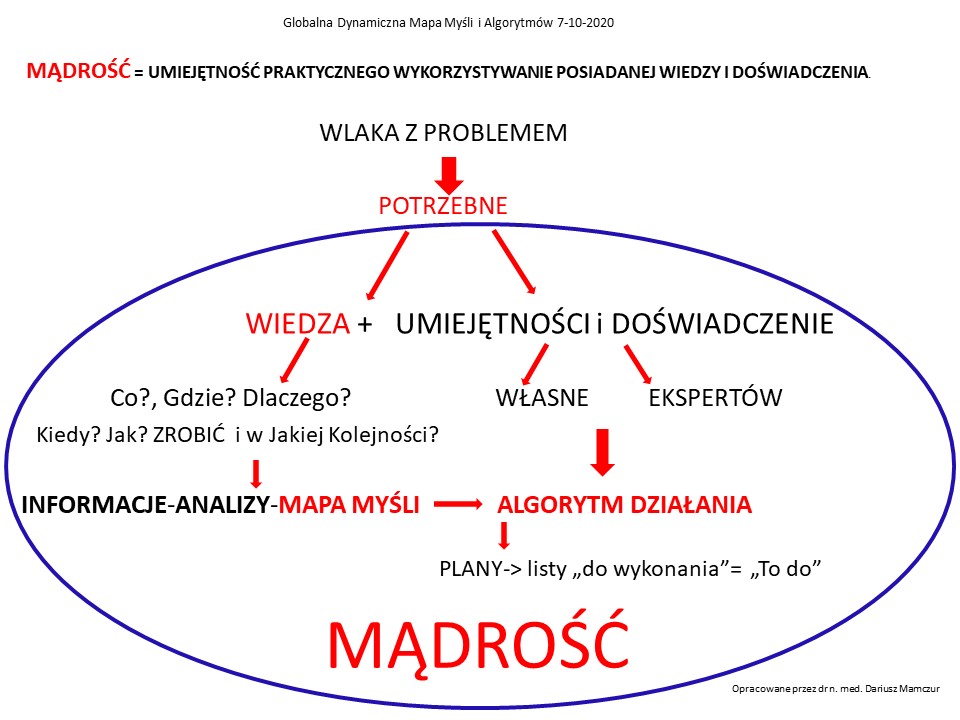

Jak budować Mapy Myśli i Algorytmów –

Jak budować Mapy Myśli i Algorytmów –

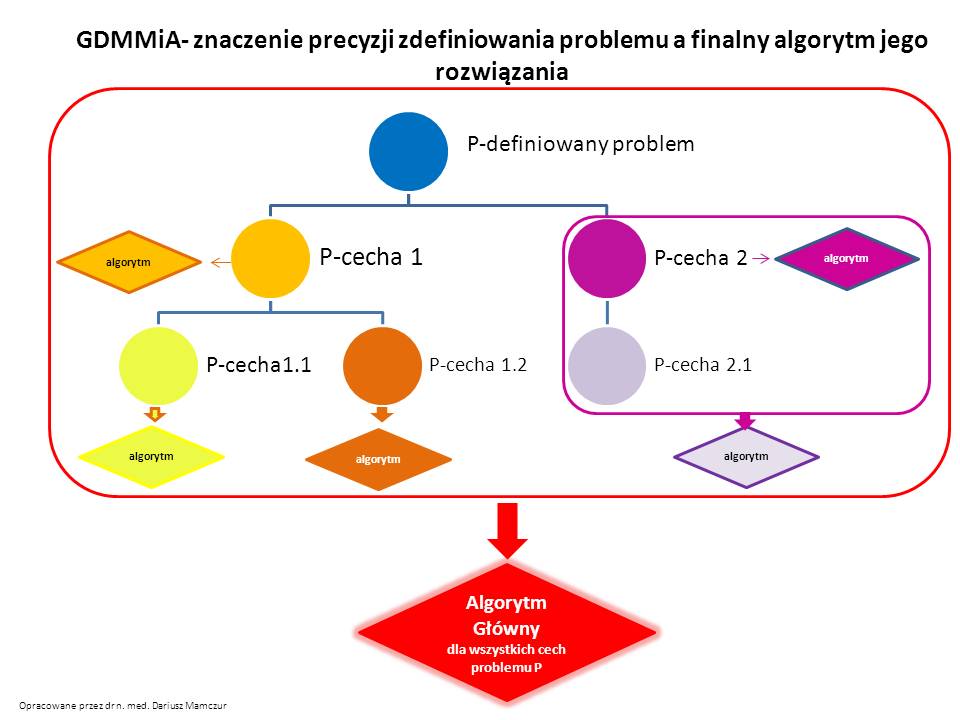

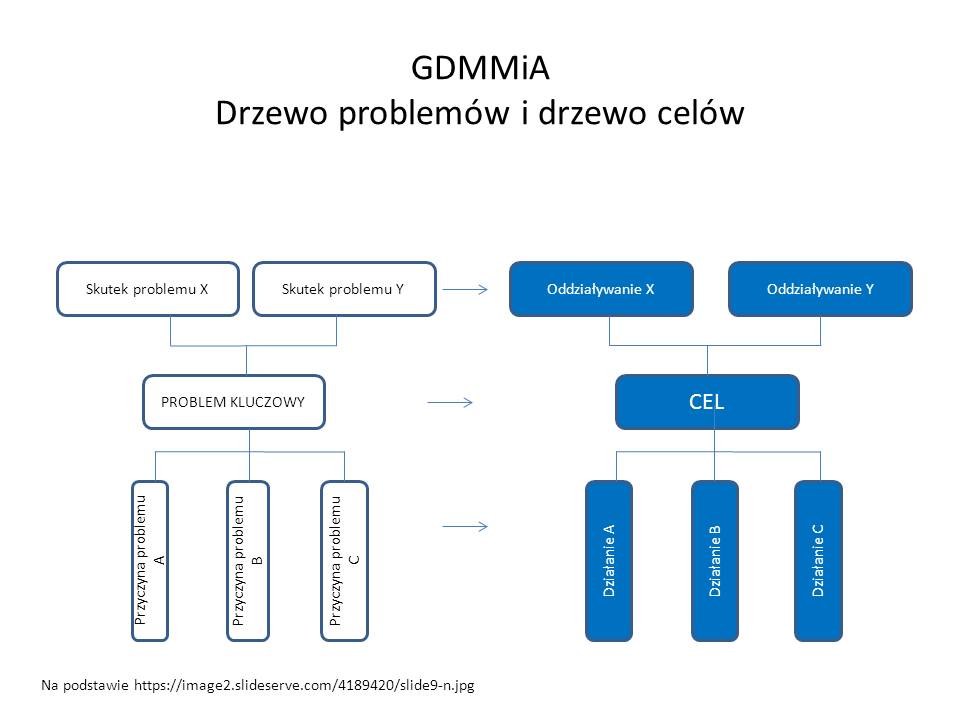

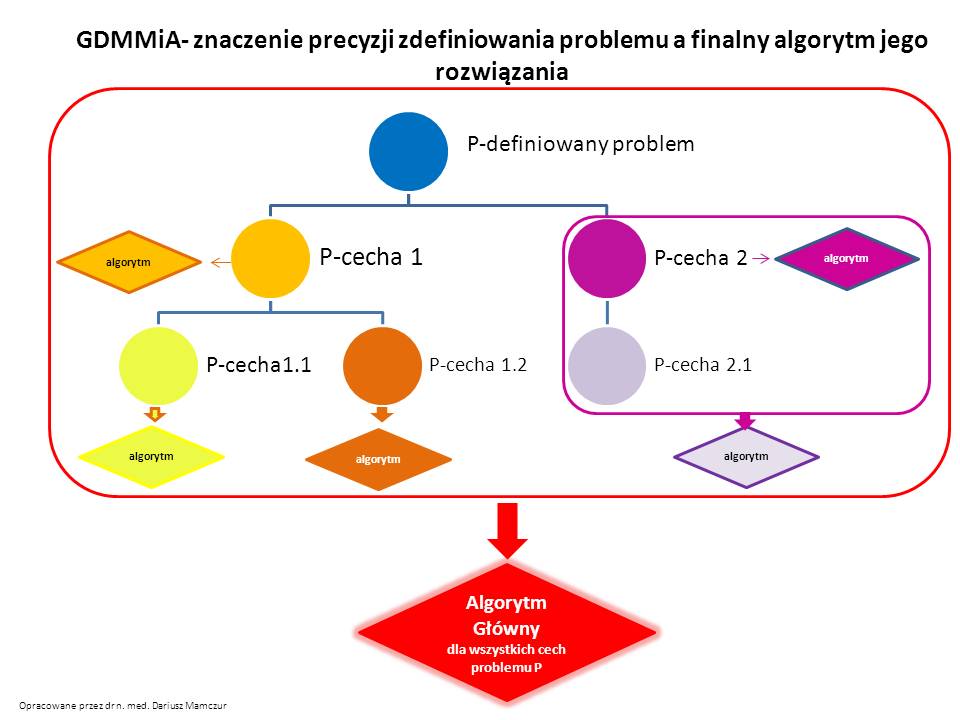

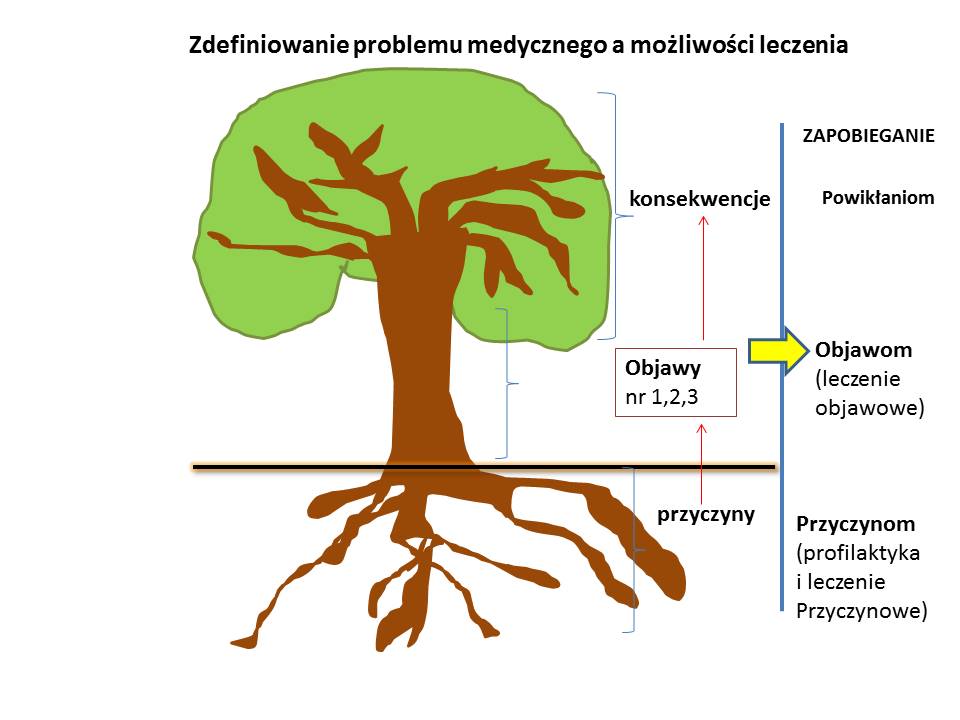

Utworzyć strukturę Mapy ( klasyfikację na wzór np. klasyfikacji wyrobów i usług). W rozwiązywaniu problemów bardzo ważne jest precyzyjne zdefiniowanie problemu.W definiowaniu problemu przydatne są poprzednie mapy lub nowe ich tworzenie w oparciu o aktualne fakty lub burzę mózgów.

Pytamy: “Na czym dokładnie polega problem!”

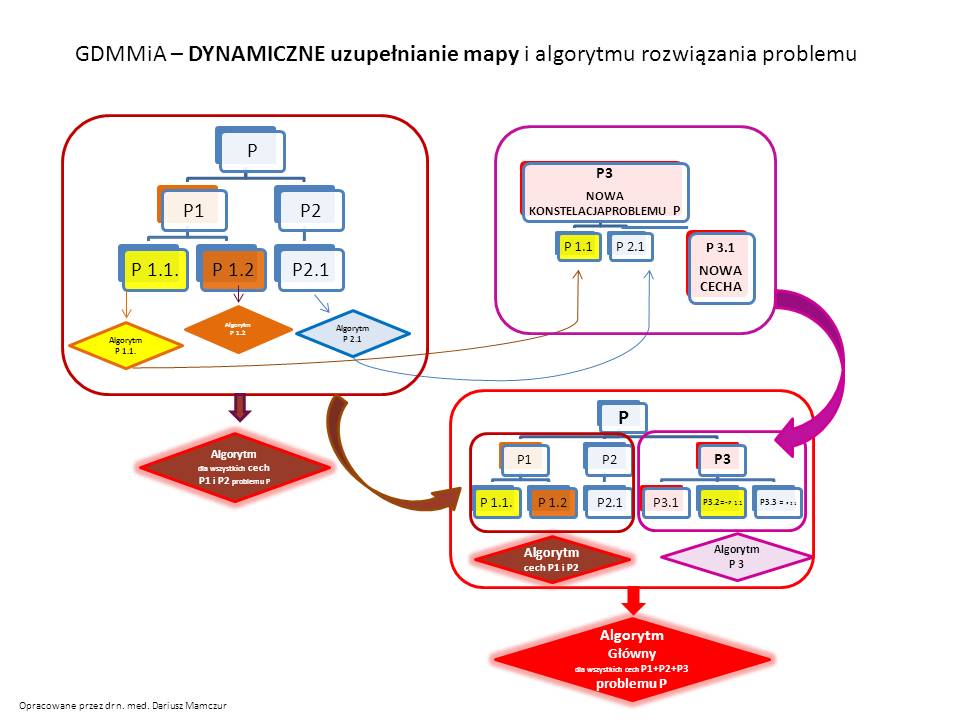

Niepełna definicja problemu może prowadzić do zupełnie innych rozwiązań. Równocześnie może się zdarzyć sytuacja odwrotna. Wcześniej mieliśmy rozbudowany problem, z wieloma jego cechami, a w naszej sytuacji jest znacznie prostszy model. Możemy wówczas wykorzystać prostszy algorytm opracowany np. tylko dla dwóch cech.

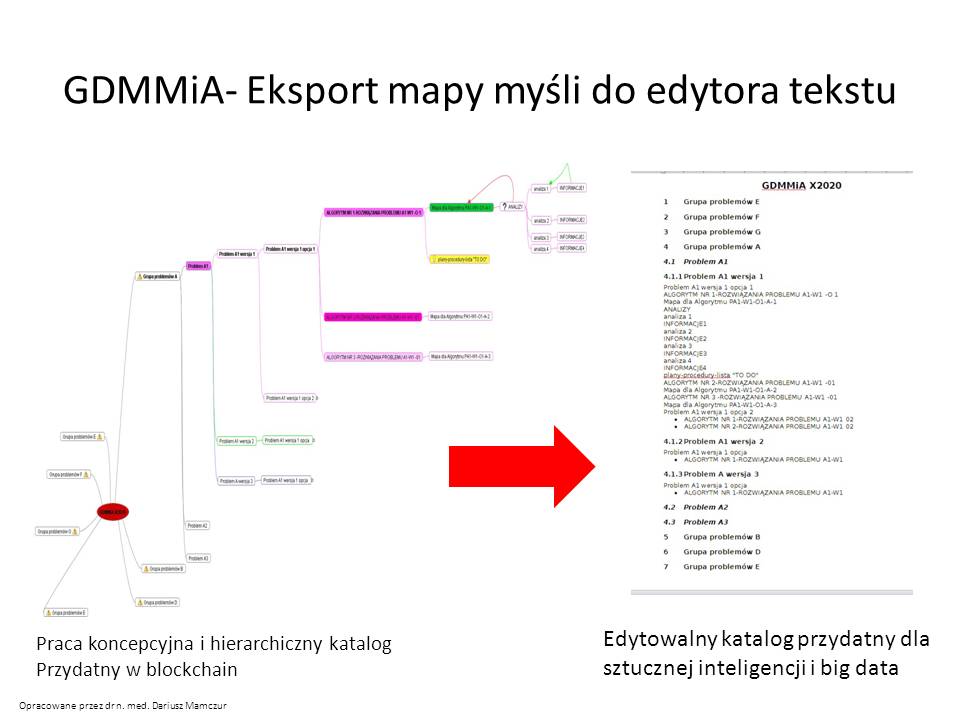

Jeśli zarządzanie wyszukiwaniem algorytmów będzie wymagało ustrukturyzowanej hierarchicznej wersji tekstowej w edytorach tekstu – można wyeksportować mapy do plików tekstowych np. w edytorach word, czy openwriter.

Zaleta tego projektu może być łatwe i kontrolowane aktualizowanie potrzebnych nam algorytmów. Na przykład jeśli mamy algorytm opinii prawnej na dzień 1 stycznia roku 2020, a prawo zmieniono wczoraj o nowe paragrafy i wykreślono niektóre regulacje – mapa pozwala stworzyć aktualna wersję opinii prawnej – zachowując nadal aktualne przepisy o nowe rozwiązania – w wielu różnych konstelacjach opracowań eksperckich.

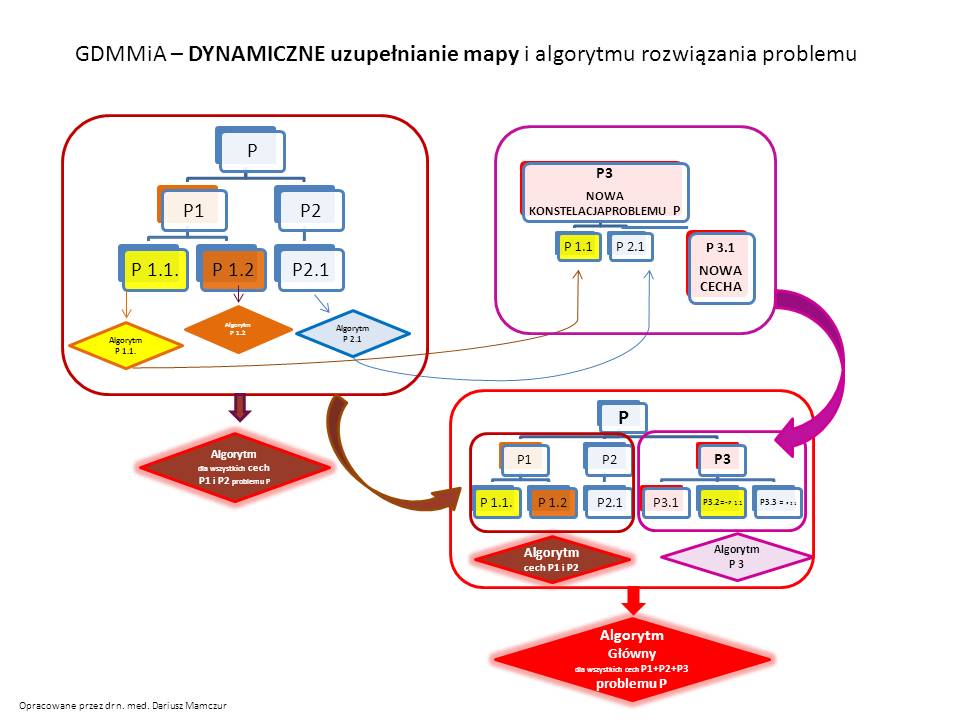

Dodawanie nowych cech do rozwiązywanego problemu może tak wyglądać

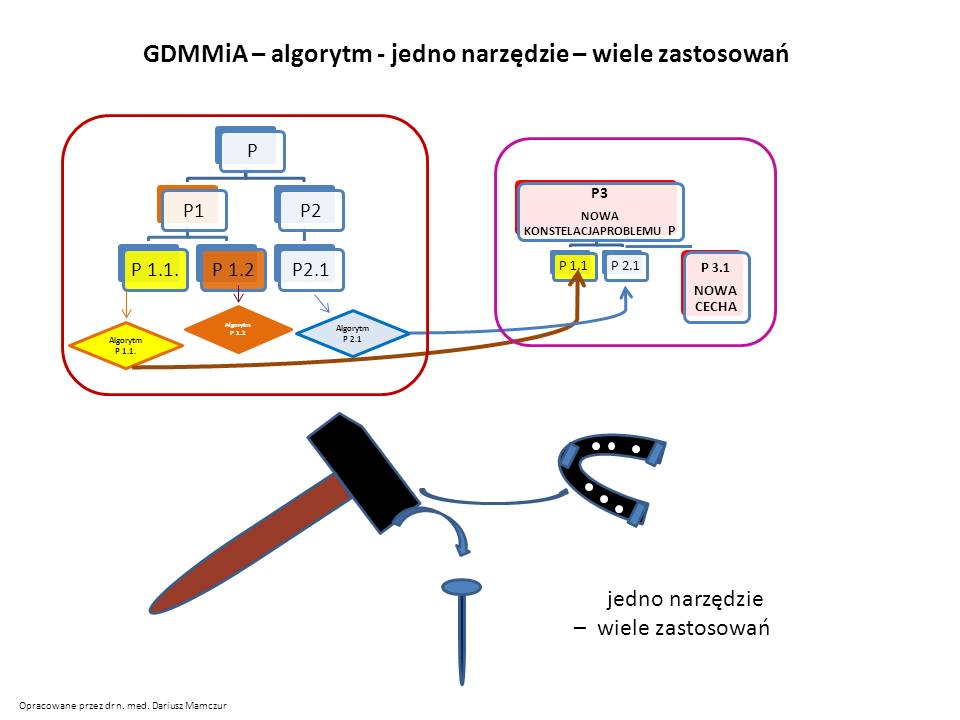

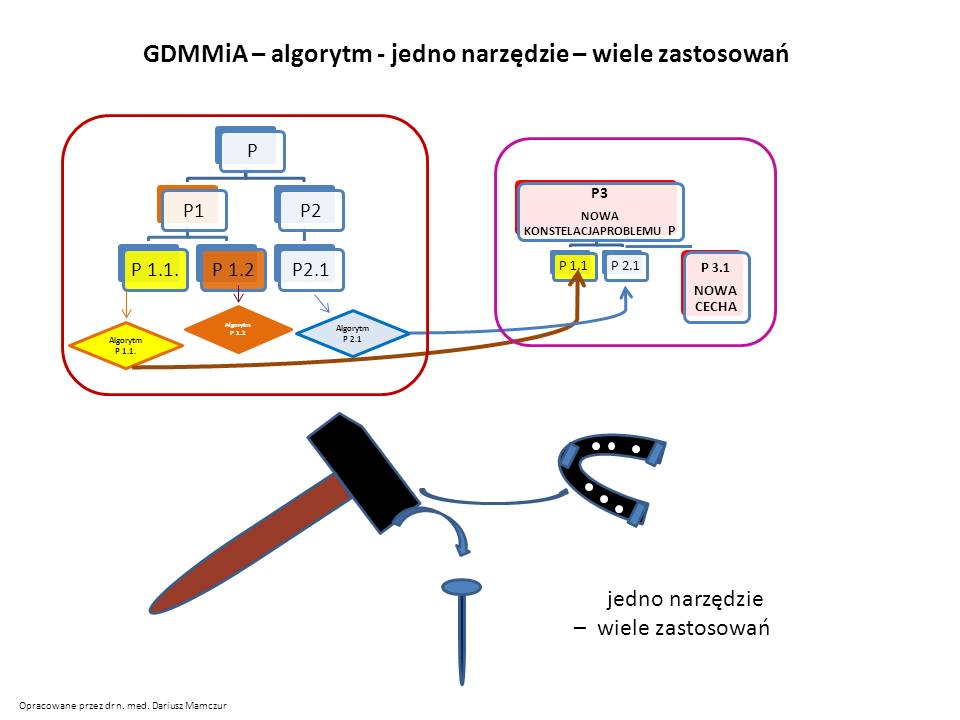

Jak widać, już raz opracowany algorytm można wykorzystać w innej konstelacji. To jest kolejna zaleta GDMMiA. Czerpiemy mądrość z poprzednich rozwiązań. jeśli sprawdziły się one wcześniej w praktyce, to maja one ogromną wartość. Unikamy błędów, o których nawet byśmy nie pomyśleli, oszczędzamy pieniądze oraz najważniejsza walutę jaka jest CZAS. Powstanie wówczas powiedzenie Człowiek ( w tym Polak) przed szkodą nie jest głupi. 🙂

Jak widać, już raz opracowany algorytm można wykorzystać w innej konstelacji. To jest kolejna zaleta GDMMiA. Czerpiemy mądrość z poprzednich rozwiązań. jeśli sprawdziły się one wcześniej w praktyce, to maja one ogromną wartość. Unikamy błędów, o których nawet byśmy nie pomyśleli, oszczędzamy pieniądze oraz najważniejsza walutę jaka jest CZAS. Powstanie wówczas powiedzenie Człowiek ( w tym Polak) przed szkodą nie jest głupi. 🙂

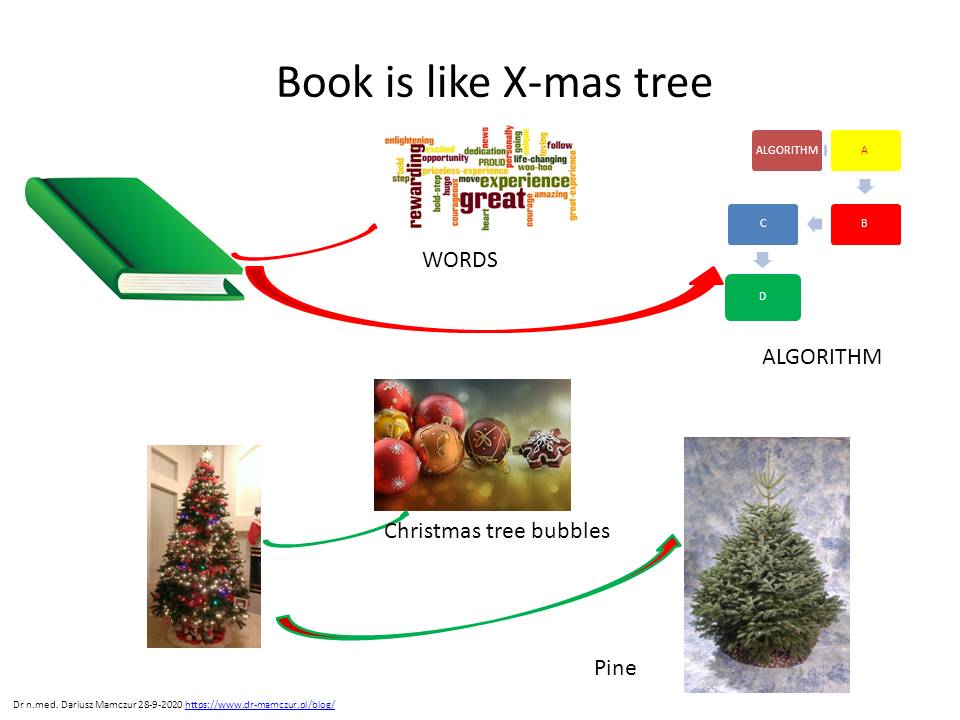

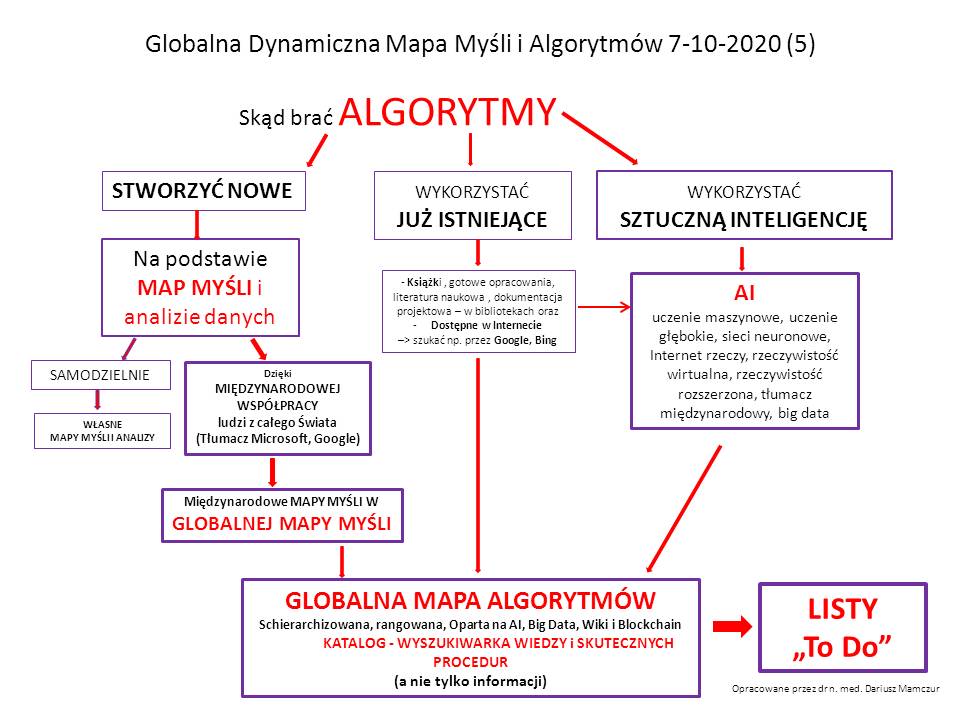

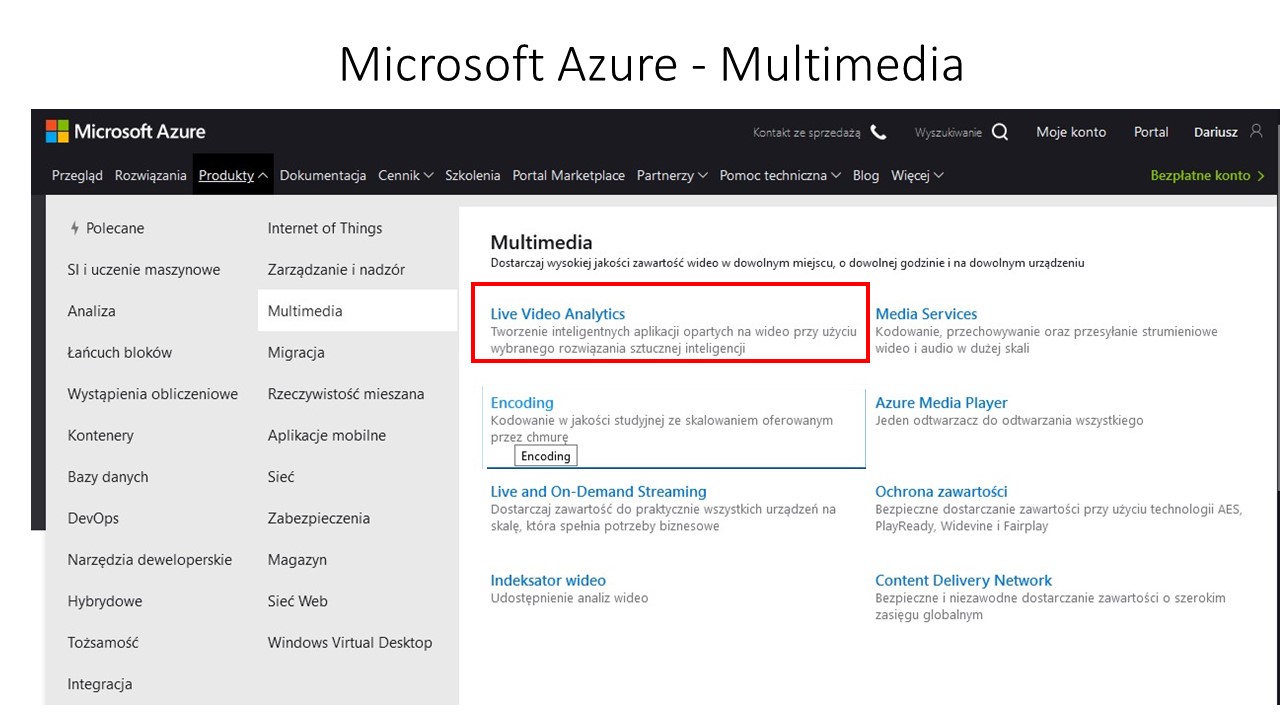

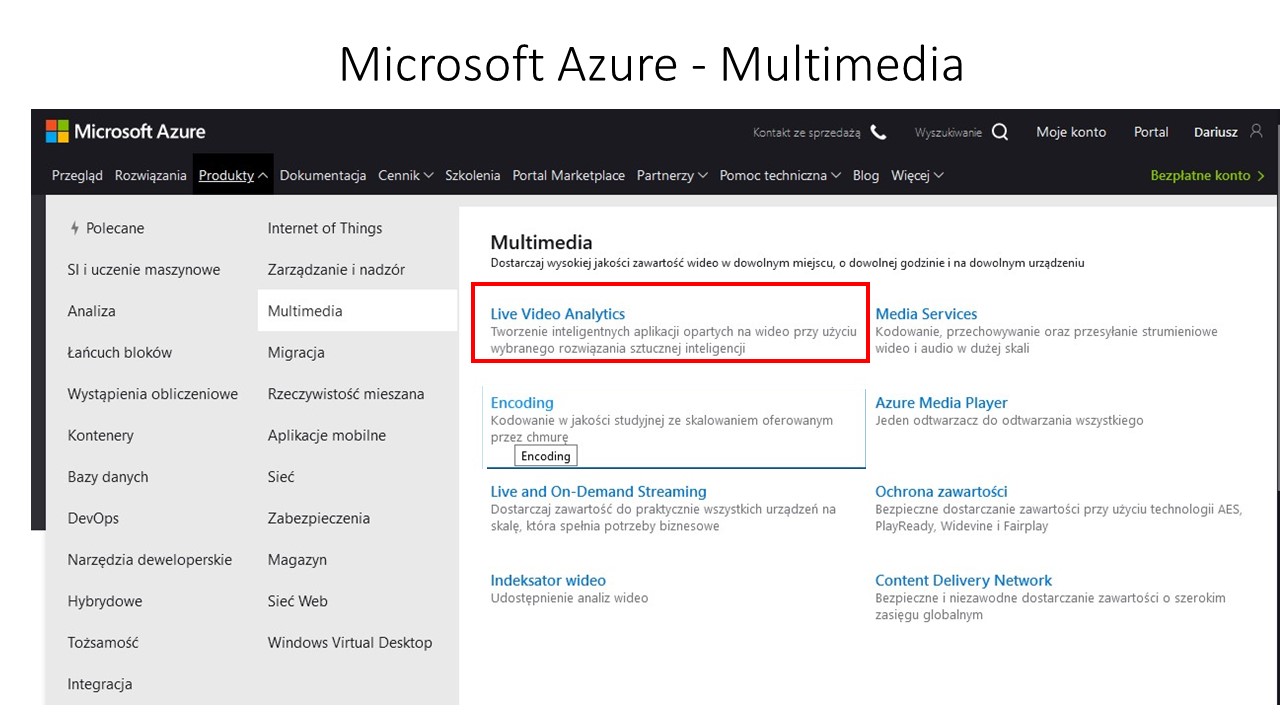

Źródłem Mapy Algorytmów będą dotychczasowe algorytmy opisane w literaturze (szczególnie naukowej) i planach zrealizowanych z sukcesem projektów, procedury opisane w tysiącach firm. Uzupełnieniem może być sztuczna inteligencja, która przeanalizuje i przełoży tekst pisany lub grafiki, filmy na algorytmy (np. książkę przedstawi w postaci algorytmu w trybie – “Co autor miał na myśli – tylko działanie a nie opisy słowne).

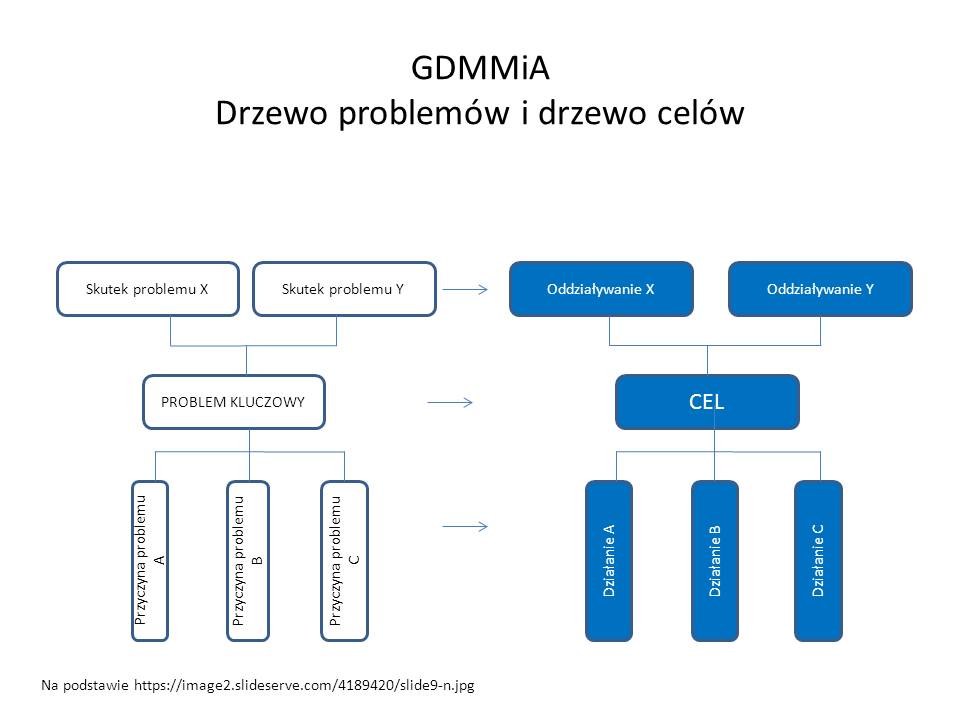

W tworzeniu map myśli (Szczególnie ALGORYTMÓW) przydatne są drzewa decyzyjne (problemów i celów oraz strategiczne)

Dodawać do mapy będzie można po zweryfikowaniu nowych elementów, zachowując chronologię i autentyczność nowego schematu, stworzyć system weryfikacji jakości map (rangowanie, ocena społeczna, ocena AI). Stabilność projektu (ochronę przed hakerami), chronologię dodawania rekordów, a co za tym idzie prawo autorskie i wynalazcze może zagwarantować technologia BLOCKCHAIN. Technologia ta pozwoli także na komercyjne wykorzystanie GDMMiA dzięki tokenizacji i możliwości płatności kryptowalutami (np. Bitcoin) . Daje to GLOBALNY zasięg projektu.

Np. jeśli przedsiębiorca amerykański będzie chciał zainwestować w Polsce – może wykupić ekspertyzę znajdująca się w GDMMiA lub poprosić o jej odpłatne uzupełnienie przez prawników w USA i Polsce. Prawnicy mogą bardzo szybko dodać takie rozwiązania do GDMMiA i później odpłatnie je udostępniać innym klientom.

Do mapy będą dodawane “cegiełki” map.

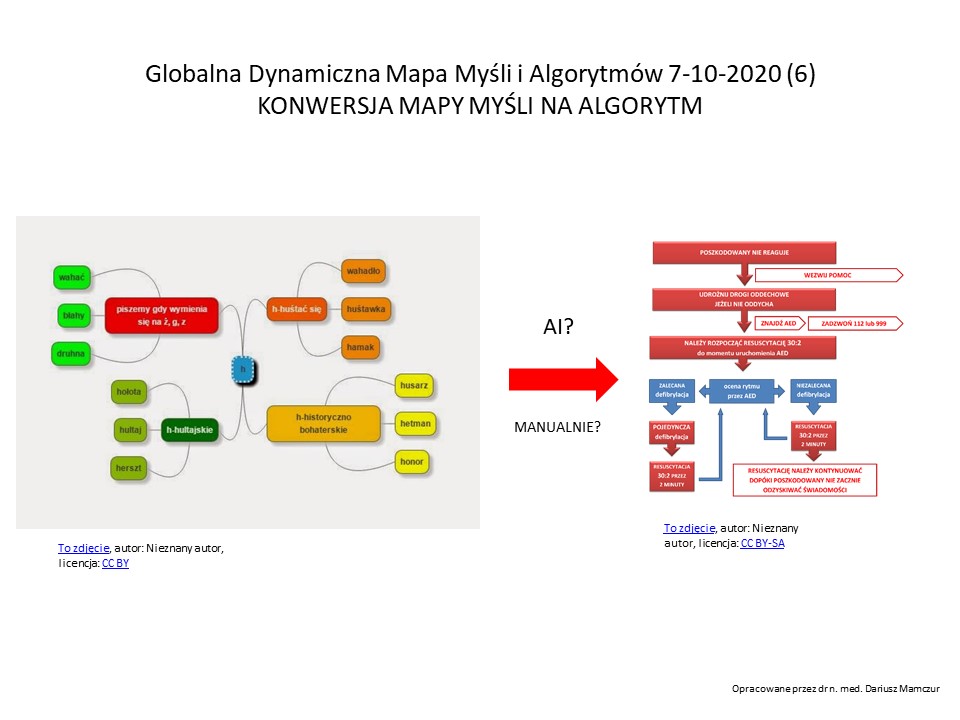

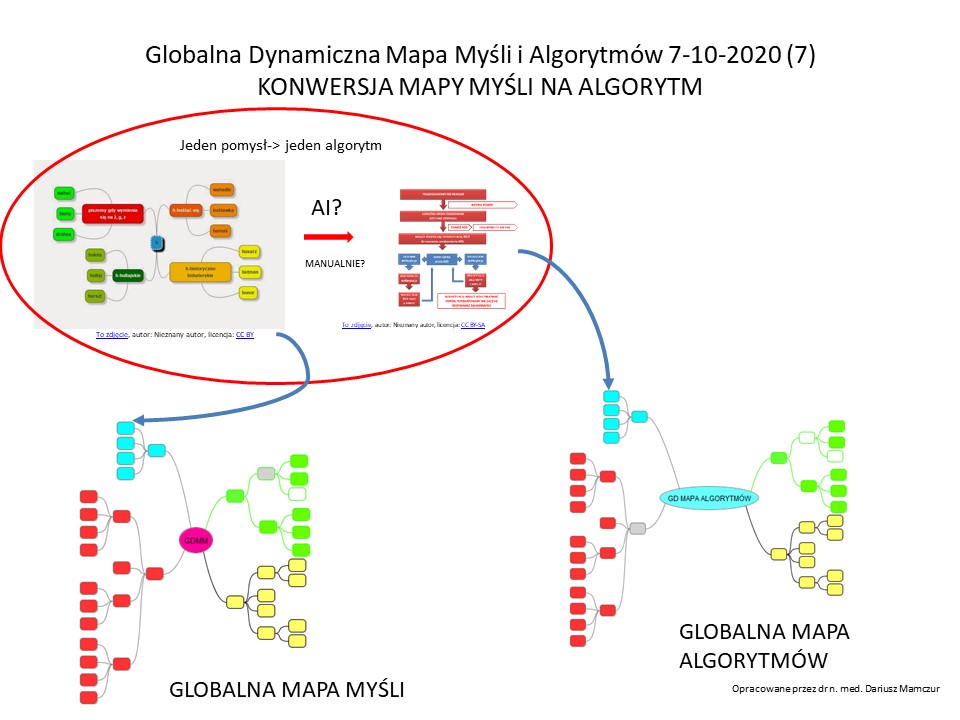

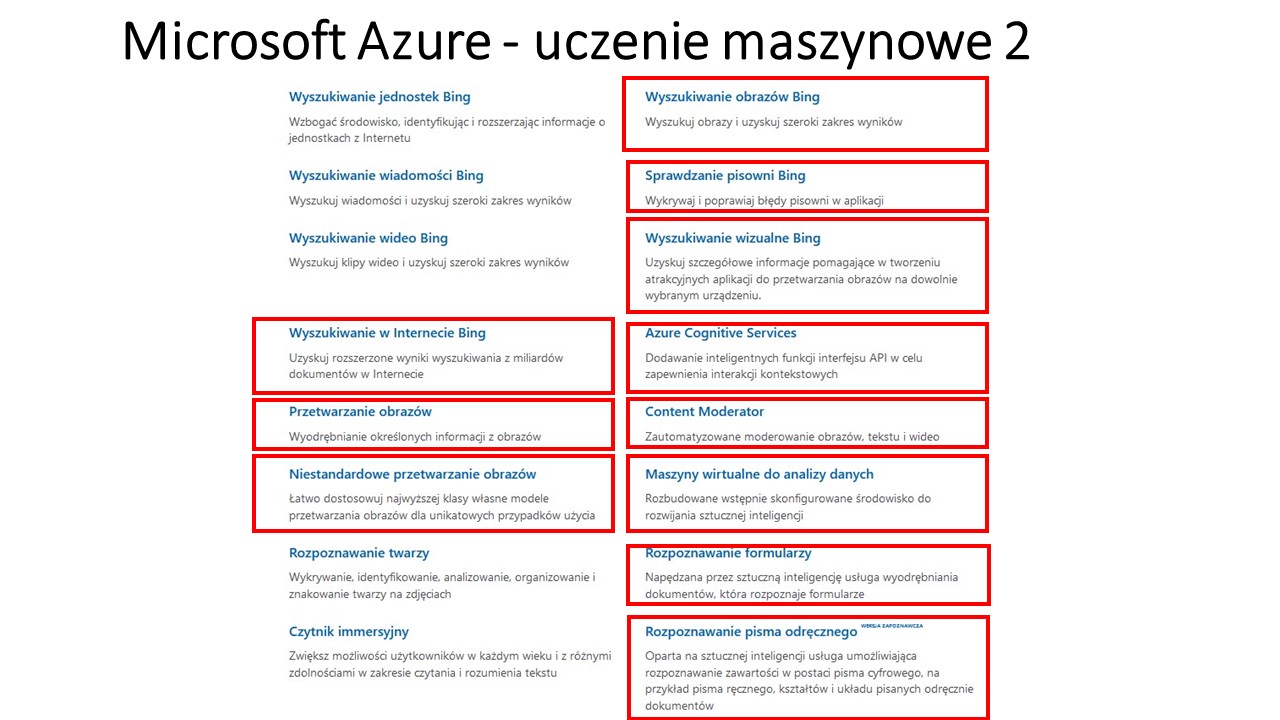

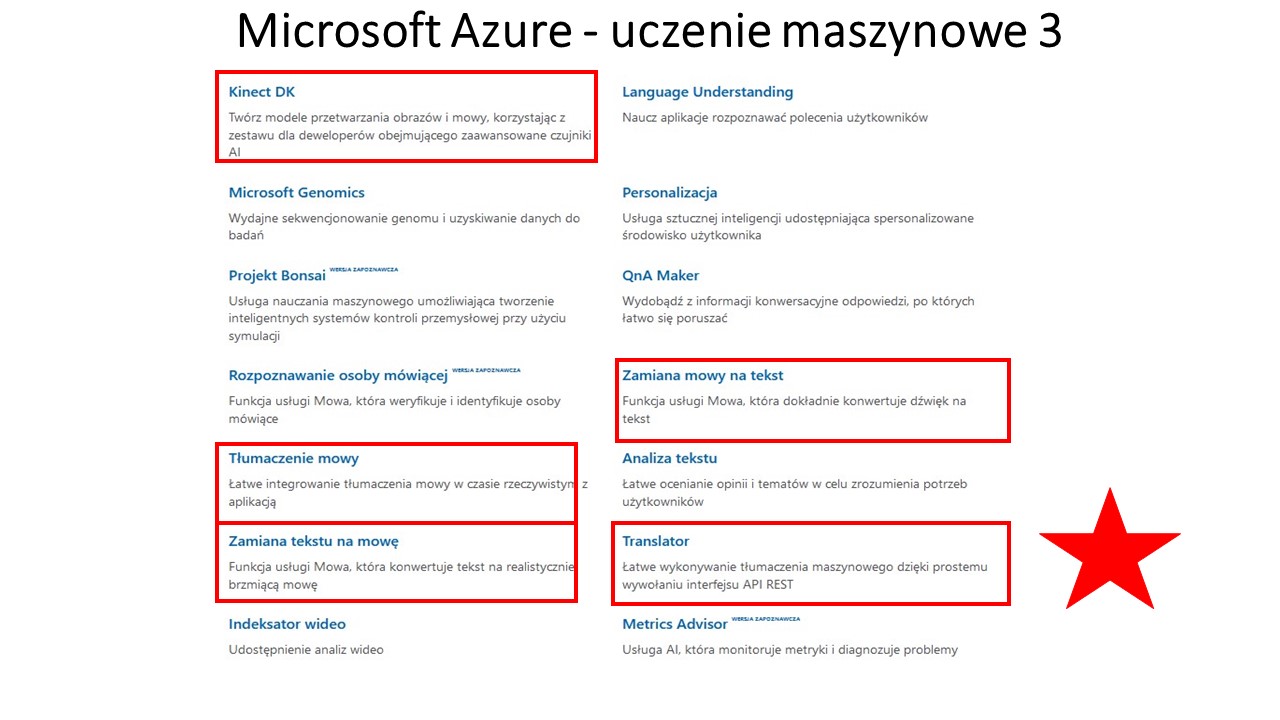

Jak współtworzyć Mapy przy udziale sztucznej inteligencji (AI) – wykorzystać AI do konwersji tekstów pisanych, filmów, obrazów, dźwięków, zapachów, dotyku na algorytmy. Algorytmy dodawać do GDMMiA

Jak tworzyć listy To Do z Algorytmów – konwersja na pliki tekstowe lub graficzne

Jak tworzyć listy To Do z Algorytmów – konwersja na pliki tekstowe lub graficzne

Jak eksportować dane z Mapy Myśli

Proszę zauważyć, że ładniej można by to zaprezentować, przy automatycznej zamianie obrazu na algorytm, gdyby było takie narzędzie? Ilu programistom oszczędziłoby to czasu przy przelewaniu swoje myśli z kartki papieru na algorytmy w komputerze?

Proszę zauważyć, że ładniej można by to zaprezentować, przy automatycznej zamianie obrazu na algorytm, gdyby było takie narzędzie? Ilu programistom oszczędziłoby to czasu przy przelewaniu swoje myśli z kartki papieru na algorytmy w komputerze?

JAK KOMERCJALIZOWAĆ PROJEKT? (wstępny projekt z 2011 r)

Komercjalizacja i finansowanie projektu.

Komercjalizacja i finansowanie projektu.

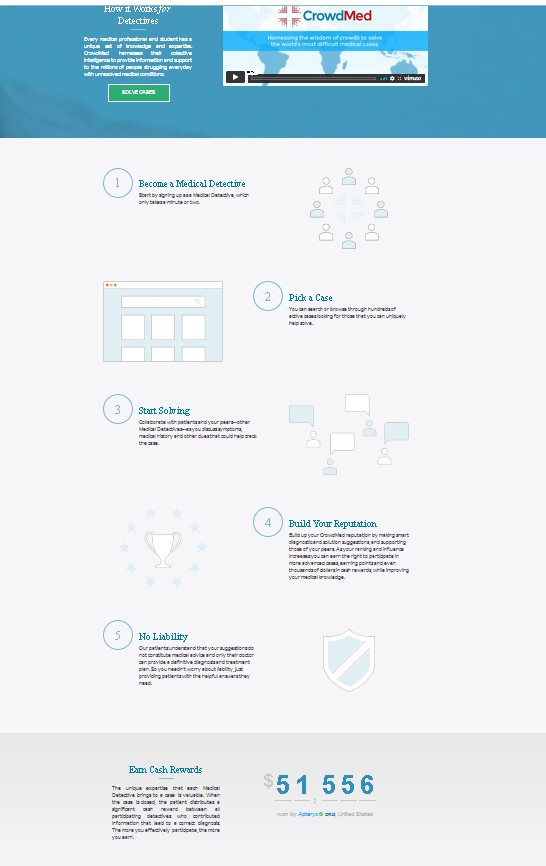

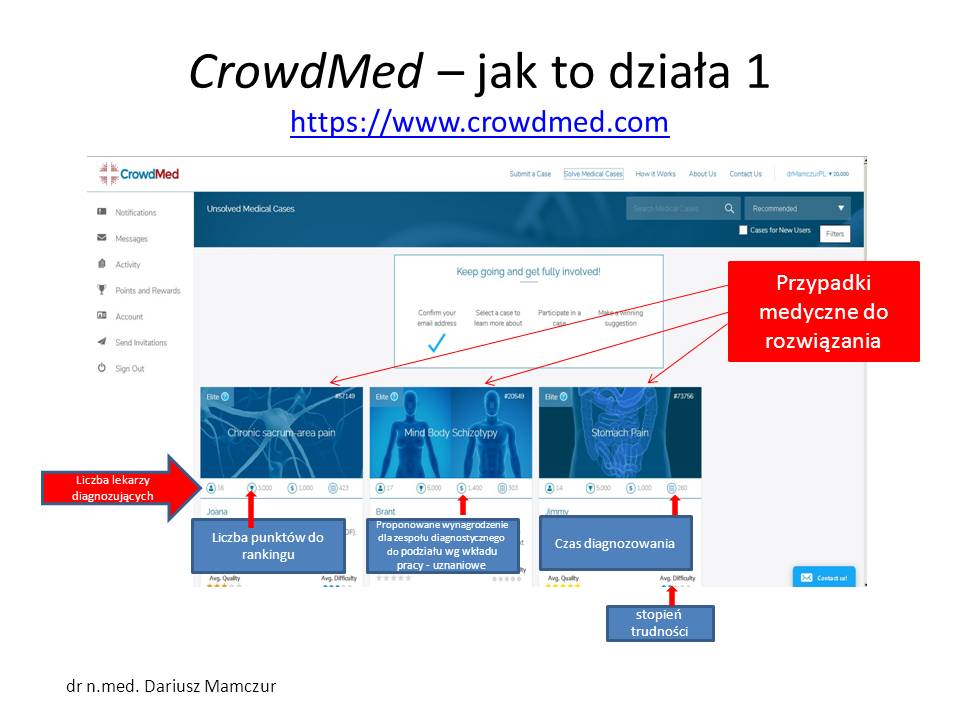

Tworzenie bazy wiedzy z częściowo odpłatnym dostępem. Klient zamawia ekspertyzę – płaci- portal wykorzystuje swoje bazy + sztuczna inteligencje i płatnych ekspertów -> płatna ekspertyza. Wynik ekspertyzy dodawany jest automatycznie do mapy myśli i algorytmów – do wykorzystania w kolejnych ekspertyzach. Można szukać inwestorów – np. crowdfunding.

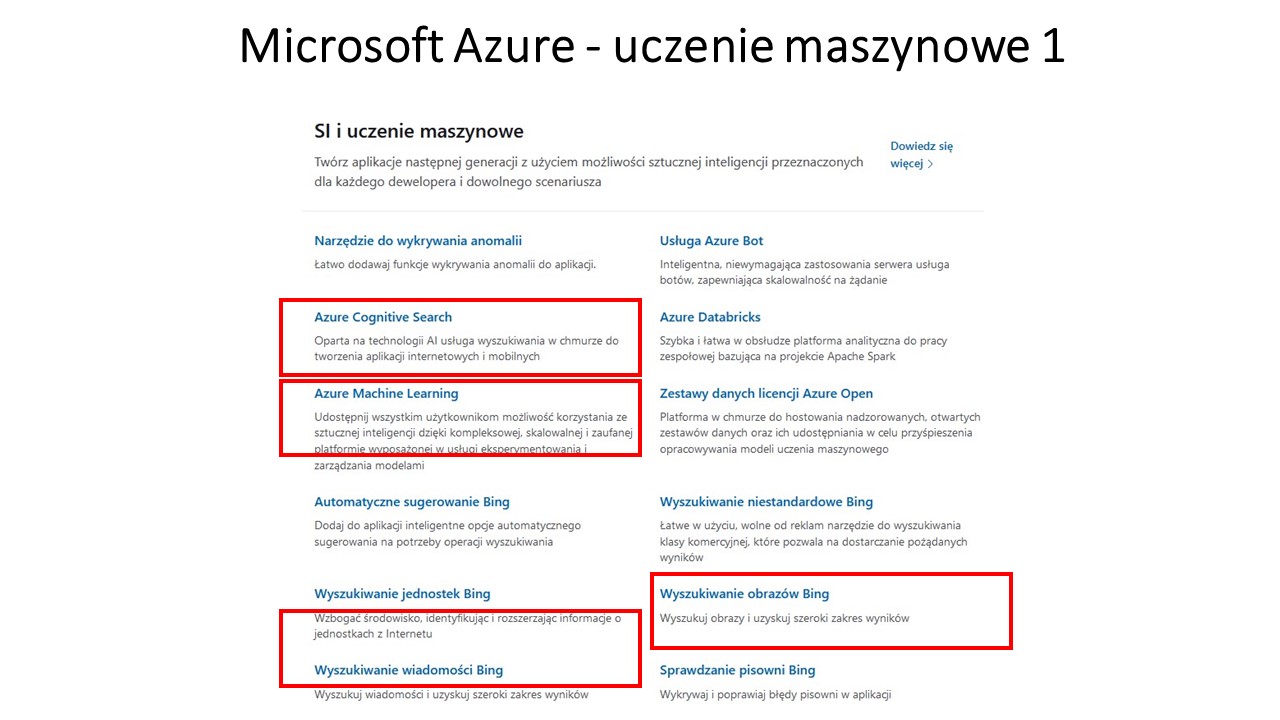

Jak zrealizować projekt

Prace nad projektem można zacząć od prostego narzędzia do konwersji plików graficznych do map myśli i algorytmów! Przydatne będzie narzędzie do automatyzowania tworzenia algorytmu z mapy myśli.(Sztuczna inteligencja, Uczenie maszynowe? sieci neuronowe, przetwarzanie języka naturalnego, translatory typu Tłumacz Goolgle). Trzeba połączyć zbieranie informacji, ich analizę i wyciąganie wniosków z tworzeniem list “To do”

(

(