Jestem lekarzem z 40 letnim stażem pracy. Zaczynałem pracę jako w epoce “analogowej” – tj. przed komputerami, Internetem, smartfonem. Zdobywanie wiedzy opierało się na papierowych czasopismach, podręcznikach, a przede wszystkim uczeniu się od doświadczonych lekarzy. Uczono nas logicznego myślenia, zbierania wywiadu oraz dokładnego badania przedmiotowego, rozpoznania różnicowego oraz racjonalnie uzasadnionych sposobów leczenia.

Wejście nowych technologii diagnostycznych zmniejszyło wagę jaką młodzi lekarze zaczęli przywiązywać do badania przedmiotowego. O wiele prościej było wykonać badanie USG, czy zlecić TK, MR. Z czasem zaczęto częściej bezkrytycznie podchodzić do wyników tych badań, traktując je jako nieomylne. (a przecież wynik może omyłkowo pochodzić od innego pacjenta, wykonujący może pominąć lub źle ocenić zmiany).

Pojawienie się informatyzacji i Internetu wprowadziło nowe możliwości zdobywania wiedzy, nauki oraz wykorzystania systemów ekspertowych. Narzędzie te były jeszcze pod kontrolą procesu myślowego lekarza. Opierały się na jasnych algorytmach decyzyjnych (można było je wydrukować, prześledzić, gdzie powstał błąd) i umożliwiały m.in. diagnostykę różnicową, przeglądanie wyników najnowszych badań naukowych.

Kolejnym krokiem w ewolucji nowoczesnej medycyny było pojawienie się w ostatnich kilku latach AI (sztucznej inteligencji). Zrewolucjonizowała ona rynek innowacji w medycynie (szczególnie w badaniach obrazowych, programach ekspertowych i poszukiwaniu nowych leków). Obecnie w start-up’ach jest “trendy”, aby tworzyć oprogramowanie w tej technologii. Pojawiły się big data, uczenie maszynowe, uczenie głębokiego (chociaż dostęp do treningowych danych medycznych jest bardzo trudny ze względów prawnych) w oparciu o sztuczne sieci neuronowe, rozszerzonej i wirtualnej rzeczywistości (AR, VR), neurolingwistykę. Z założenia mają one dostarczyć lekarzowi narzędzia diagnostyczno-terapeutyczne i ułatwić podejmowanie decyzji lekarskich. Czyli odciążyć proces myślenia lekarza. Niestety obawiam się, że podawanie decyzji “na tacy” (bez ich logicznego uzasadnienia) może spowodować utratę nawyków krytycznego myślenia lekarskiego. Jak często się powtarza “narząd nieużywany ulega zanikowi” :). Trzeba wznawiać nawyki myślowe i manualne (tak jak się to robi w szkoleniu pilotów). Zdanie się tylko na AI może to spowodować, że lekarz pozbawiony swoich “analogowych” umiejętności stanie się bezkrytycznym cyborgiem, nie zawsze podejmujące decyzje zgodnie z zasadą ” przede wszystkim nie szkodzić”. Wojna w Ukrainie pokazuje nam także, że bark dostępu do urządzeń cyfrowych wymaga od lekarza działania bez najnowszych zdobyczy technologicznych (bez internetu, prądu, laboratorium, pracowni diagnostycznych) – zostaje to mówiono nam w WAM – “mózg i mięśnie”. Dlatego uważam, że obecne programy edukacyjne i ekspertowe powinny mieć element szkolenia analogowego (uczyć myślenia krytycznego i analityczno – różnicowego). Powinno się tłumaczyć, jak doszło się do danego wniosku (rozpoznania), dlaczego dana decyzja jest najlepsza. Na jakie błędy możemy być narażenie (wpis – błąd medyczny a lekarski). Nie wystarczy wynik, że AI daje np. 85% prawdopodobieństwo poprawnie postawionej diagnozy (bo AI tak uzasadnia swoje decyzja – tylko w PRAWDOPODOBIEŃSTWIE!).

Na rynku istnieje wiele rozwiązań AI wykorzystywanych w nauczaniu studentów medycyny. W Polsce możemy się pochwalić np.

“Wirtualną Kliniką” – firmy BD Polska Sp. z o.o.

Saventic – w diagnostyce chorób rzadkich

Na rynku medycznym są to bardzo drogie przedsięwzięcia oparte na AI – dla przykładu angielski program dla lekarzy GP firmy Babilon (GP at hend) kosztował już miliony funtów – i ciągle się “uczy” :).

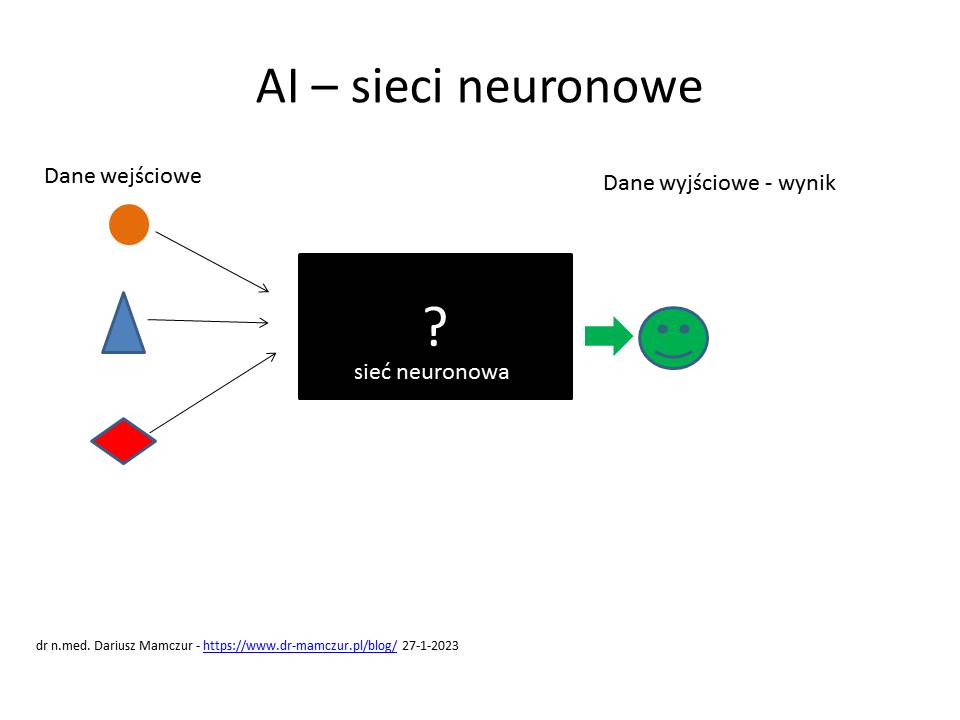

Głębokie uczenie w wielowarstwowych sztucznych sieciach neuronowych. jest dla informatyków podobno “czarną skrzynką”. Znają dane wejściowe i wyjściowe. Niestety nie mogą opisać jak sieć się nauczyła i jak to działa wewnątrz wielu warstw oprogramowania.

(coś wychodzi, ale nie wiadomo dlaczego)

Na razie nadal istnieje jednak duże ryzyko tej technologii. Może ona popełniać błędy z różnych powodów. Nie mamy nad nią kontroli i racjonalnego wytłumaczenia sposobu wnioskowania decyzyjnego.

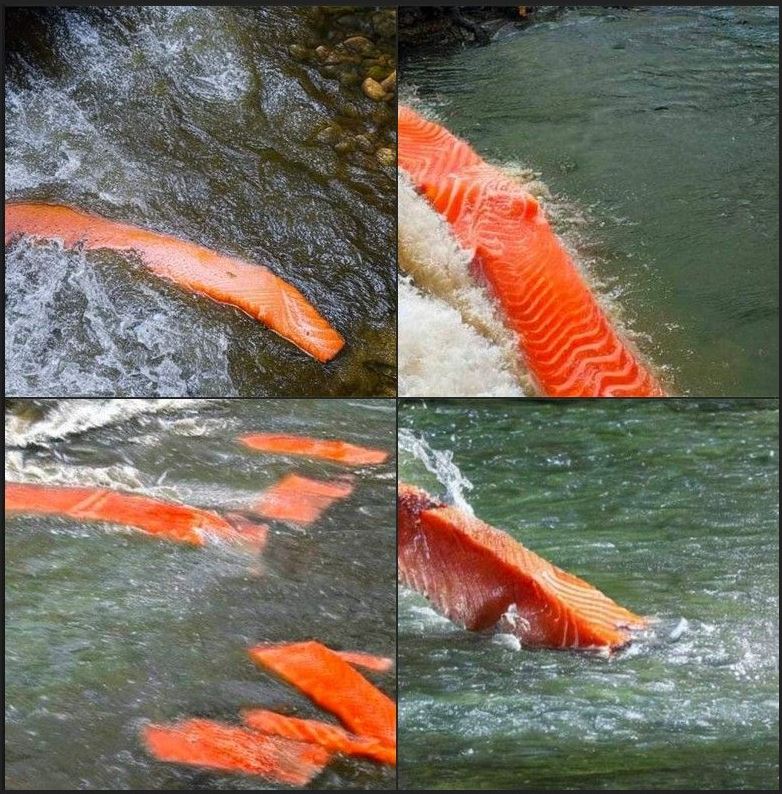

Paradoksalnie może dochodzić do sytuacji jak na przedstawionym poniżej zdjęciu.

Np. AI poproszona o wykreowanie łososia płynącego rzeką może stworzyć taki obraz. (udostępnione przez Carlos la Orden Tovar)

Niestety takie błędy w programach edukacyjnych i ekspertowych mogą kosztować życie. Nadanie oprogramowaniu certyfikatów “wyrobu medycznego” – powinno być obwarowane wieloma opiniami lekarzy i testami. (takie rozwiązania są planowane w Polsce)+ konsultacje z NIL (URPLWMiPB) . Stosuje się je w Wielkiej Brytanii MHRA)-